Réaliser un Agent pour QA des Scrapings

Guide complet pour concevoir et déployer un agent de qualité pour l'extraction de données

Highlights

- Définition claire des objectifs et des critères de qualité pour garantir l'exactitude et la cohérence des données extraites.

- Architecture modulaire intégrant modules de scraping, validation, analyse et reporting pour un contrôle continu.

- Intégration d'outils et technologies spécifiques (ex. Python, Selenium, Scrapy, frameworks d'IA) afin d'automatiser la QA et optimiser les performances.

Introduction

Dans le domaine du web scraping, la qualité de l'extraction des données est primordiale pour garantir que les informations récupérées soient fiables et utilisables. Pour cela, la mise en place d’un agent dédié à la Quality Assurance (QA) permet d’automatiser la vérification et la validation des données extraites. Ce guide détaillé explique comment concevoir et déployer un tel agent, en combinant différentes technologies et approches qui ont fait leurs preuves.

1. Définition et Objectifs

La première étape essentielle consiste à définir précisément les objectifs du projet et les critères de qualité des scrapings. Il s'agit de déterminer ce qui sera considéré comme une extraction réussie afin de pouvoir intervenir si besoin.

1.1 Objectifs Principaux

- Assurer que les données collectées répondent à des normes de qualité préétablies (exactitude, complétude, cohérence).

- Minimiser les erreurs et les anomalies lors de l’extraction, tout en anticipant les changements sur les sites sources.

- Optimiser le processus automatique de QA pour réduire les interventions manuelles et améliorer l’efficacité globale.

1.2 Critères de Qualité

Les critères de qualité définissent les seuils d’acceptabilité pour les données extraites. Parmi ceux-ci, on retrouve :

- Précision : Les données doivent être correctement extraites et correspondre exactement à ce qui est présent sur la source.

- Complétude : Toutes les informations requises doivent être présentes.

- Cohérence : Les données ne doivent pas présenter d’incohérences ou de duplications.

- Rapidité : Les performances de scraping doivent respecter des temps de réponses acceptables.

2. Architecture et Composants de l'Agent

Pour réussir la QA des scrapings, une architecture modulaire et évolutive est indispensable. Chaque module remplit un rôle spécifique dans l’ensemble du processus.

2.1 Modules Clés

- Module de Scraping : Responsable de l’extraction des données. Les outils comme Selenium, Scrapy ou Beautiful Soup sont couramment utilisés.

- Module de Validation : Vérifie la qualité des données extraites selon des tests définis, comme la cohérence, l'intégrité et le formatage.

- Module d'Analyse : Utilise des algorithmes, parfois basés sur l’apprentissage automatique, pour détecter automatiquement des anomalies ou des éventuels écarts.

- Module de Reporting : Génère des rapports détaillés et des alertes pour notifier en cas de dysfonctionnements dans le processus de scraping.

2.2 Schéma de l’Architecture

L’architecture typique de cet agent peut être visualisée comme suit :

| Module | Fonctionnalité |

|---|---|

| Scraping | Extraction des données via des outils comme Selenium, Scrapy ou Beautiful Soup. |

| Validation | Exécution de tests pour valider l’exactitude, la complétude et la cohérence des données. |

| Analyse | Identification des anomalies et des incohérences grâce à des algorithmes d’IA ou de statistiques. |

| Reporting | Génération de rapports et notifications en temps réel pour un suivi régulier des résultats de QA. |

3. Technologies et Outils Recommandés

La mise en place d’un agent de QA pour le scraping repose sur une sélection judicieuse d’outils et de technologies. L’écosystème Python, notamment, s’avère particulièrement adapté pour ce genre de projet grâce à ses bibliothèques spécialisées et sa communauté active.

3.1 Langages et Frameworks

- Python : Langage privilégié pour le scraping et l’automatisation grâce à ses bibliothèques robustes.

- Selenium : Permet d’automatiser la navigation dans les pages web et d’interagir avec les éléments dynamiques.

- Scrapy : Framework de scraping puissant qui offre des fonctionnalités avancées pour l'extraction de données.

- Beautiful Soup : Bibliothèque permettant de parser efficacement le contenu HTML pour extraire des informations.

3.2 Outils d’Automatisation et d’IA

- Pytest : Pour intégrer des tests automatisés et vérifier la qualité des données extraites lors de chaque exécution.

- Pandas : Pour manipuler et analyser les données de manière efficace, facilitant la détection d'anomalies.

- Frameworks d'apprentissage automatique : Tels que Scikit-Learn ou TensorFlow, pour améliorer la capacité de l’agent à identifier des erreurs ou des patterns inattendus dans les données.

- LangGraph ou autres outils d'agents autonomes : Pour créer des flux de travail intelligents qui orientent les opérations d’extraction et de validation.

4. Processus de QA des Scrapings

Un processus structuré garantit la réussite de la QA. Voici les étapes détaillées pour mettre en place ce processus :

4.1 Extraction des Données

L’agent de scraping doit d’abord récupérer les données depuis une source en utilisant les outils adaptés. Lors de cette phase, il est important de simuler de manière réaliste l’activité d’un utilisateur pour éviter d’être bloqué par des protections contre les robots. Pour cela, on peut modifier les chaînes d’agent utilisateur ou utiliser des proxies pour diversifier les requêtes.

4.2 Validation et Tests

Après l’extraction, le module de validation passe en revue les données pour s’assurer qu’elles répondent aux critères de qualité établis. Ce processus implique différents types de tests, notamment :

- Tests d’intégrité : Vérifier que toutes les informations attendues sont effectivement présentes et sans lacunes.

- Tests de formatage : S'assurer que les données respectent un format spécifique (ex. formats de date, nombres correctement structurés).

- Tests de cohérence : Comparer les données obtenues avec des valeurs de référence pour détecter des écarts ou anomalies.

4.3 Analyse des Données

L'analyse approfondie des données extrait permet de détecter des problèmes potentiels. Grâce à des algorithmes statistiques ou d’apprentissage automatique, l’agent peut identifier des schémas anormaux ou des incohérences nécessitant une révision. Par exemple, il peut repérer des valeurs aberrantes ou des duplications inattendues qui indiqueraient un dysfonctionnement dans le scraping.

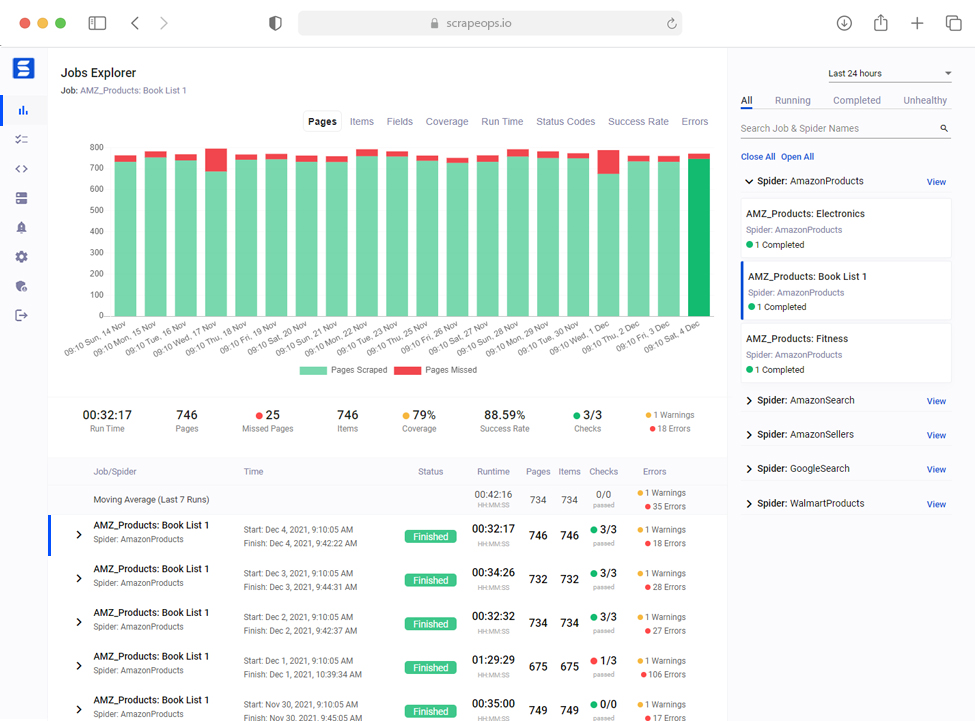

4.4 Génération de Rapports et Alertes

Le module de reporting compile les résultats de la validation et de l'analyse dans des rapports clairs et détaillés. Ces rapports peuvent être présentés sous forme de tableaux et graphiques, et des alertes automatisées peuvent être configurées pour notifier immédiatement l'utilisateur en cas de détection d'erreurs ou d'anomalies.

5. Automatisation et Maintenance de l’Agent

Pour garantir la pérennité et l'efficacité de l'agent de QA, il est essentiel d'intégrer des processus d'automatisation et de maintenance réguliers.

5.1 Intégration dans le Pipeline de Scraping

L'agent de QA doit être intégré dans le pipeline global du scraping de données. Chaque fois qu'un scraping est lancé, le processus complet de validation et d'analyse doit s'exécuter automatiquement, minimisant ainsi l'intervention humaine et permettant une vérification en continu.

5.2 Mise à jour et Adaptabilité

Le web évolue rapidement, ce qui peut affecter les sites ciblés et les méthodes de scraping. Il est important de maintenir l’agent à jour en mettant à jour régulièrement les règles de validation, en ajustant les scripts et en intégrant de nouveaux outils ou bibliothèques. Des mises à jour régulières garantissent que l’agent s’adapte aux changements et continue de fournir des résultats fiables.

5.3 Surveillance Continue et Optimisation

La surveillance continue via des dashboards et des outils d'analyse permet d'identifier rapidement toute défaillance ou baisse de performance. L’optimisation du code et l’amélioration des critères de QA sont essentielles pour maintenir un haut niveau de performance et s'assurer que les données extraites restent toujours de grande qualité.

6. Étapes Pratiques pour la Mise en Œuvre

Voici un guide étape par étape destiné aux développeurs souhaitant implémenter cet agent de QA :

Étape 1 : Définir le Cahier des Charges

Rassemblez les exigences en termes de données et de performance. Identifiez les sites à scraper, les données spécifiques à collecter et les critères de qualité (précision, cohérence, format).

Étape 2 : Choisir l’Environnement de Développement

Sélectionnez un environnement de développement approprié et configurez les bibliothèques nécessaires, telles que Python, Selenium, Scrapy, et Beautiful Soup. Assurez-vous également d’avoir des outils de tests comme Pytest pour automatiser les validations.

Étape 3 : Développer le Module de Scraping

Codez le module de scraping qui va récupérer les données en simulant une navigation réelle. Pensez à manipuler correctement les chaînes d’agent utilisateur afin d’éviter les blocages et à gérer les stratégies de proxies le cas échéant.

Étape 4 : Créer le Module de QA

Implémentez les fonctions de validation qui analyseront les données extraites. Élaborez des tests sur la structure des données, leur complétude, la vérification des duplications, et mettez en place des algorithmes capables de notifier les anomalies.

Étape 5 : Automatiser l’Intégration

Intégrez votre agent de QA dans le pipeline global du scraping pour exécuter automatiquement le contrôle qualité après chaque extraction. Configurez également un système de reporting automatique qui vous alertera en cas de problème.

Étape 6 : Déployer et Surveiller

Déployez l’agent dans un environnement cloud pour profiter d’une bonne scalabilité et mettre en place des outils de surveillance afin de suivre la performance et la qualité en temps réel. Adaptez régulièrement les scripts en fonction des retours et des évolutions des sites web.

7. Tableau Récapitulatif des Modules et Technologies

| Module | Outils/Technologies | Fonctionnalité |

|---|---|---|

| Scraping | Selenium, Scrapy, Beautiful Soup | Extraction de données brutes depuis les pages web |

| Validation | Pytest, scripts de vérification personnalisés | Test de l’intégrité, du format et de la cohérence des données |

| Analyse | Pandas, Scikit-Learn, TensorFlow | Détection des anomalies et analyse statistique des données |

| Reporting | Dashboards, scripts d’alerte, outils de visualisation | Génération et diffusion de rapports sur la QA |

8. Aspects Avancés et Intégration d'Intelligence Artificielle

L’intégration d’algorithmes d’intelligence artificielle permet de rendre l’agent encore plus performant et autonome. En analysant les données extraites au fil du temps, un système d’apprentissage automatique peut :

- Identifier des patterns récurrents d’erreurs et adapter les stratégies de scraping.

- Optimiser les seuils de validation en fonction des retours historiques et des modifications des sites web.

- Offrir une prédiction sur les éventuels blocages ou dégradations de qualité lors de futures extractions.

L’usage d’outils comme LangGraph ou d’autres frameworks d’agents autonomes améliore ainsi la capacité de l’agent à prendre des décisions et à ajuster les paramètres en temps réel.

9. Considérations de Sécurité et Gestion des Problèmes

Le web scraping peut parfois entrer en conflit avec les politiques des sites web. Pour pallier ces éventuels problèmes :

- Veillez à modifier régulièrement les chaînes d’agent utilisateur pour imiter un comportement humain.

- Utilisez des proxies et des VPN pour diversifier les adresses IP utilisées et éviter le blocage.

- Assurez-vous de respecter les conditions d’utilisation des sites web.

Une surveillance continue par le module de reporting contribuera à identifier rapidement tout comportement suspect ou toute déviation par rapport aux critères définis.

10. Ressources et Prochaines Étapes

Pour approfondir vos connaissances et perfectionner votre agent, il est recommandé de consulter diverses ressources en ligne et d'expérimenter avec des outils modernes. L'adaptation continue de vos scripts et l'intégration de retours d'expérience contribueront à l'évolution de la qualité des scrapings.

Références

- Say Goodbye to Manual Web Scraping - LinkedIn

- Creating a Scraping Agent - Agenty

- TheAgenticBrowser on GitHub - TheAgenticAI

- How to Use ChatGPT for Web Scraping in 2025 - Oxylabs

- Real-Time Web Scraping with Data Streaming - Confluent

Recommandations

Last updated March 18, 2025