解锁奥秘:如何在Isaac Sim中运用强化学习掌控四足机器人运动

一份详尽指南,助您从零开始在NVIDIA Isaac Sim中训练四足机器人实现智能运动控制。

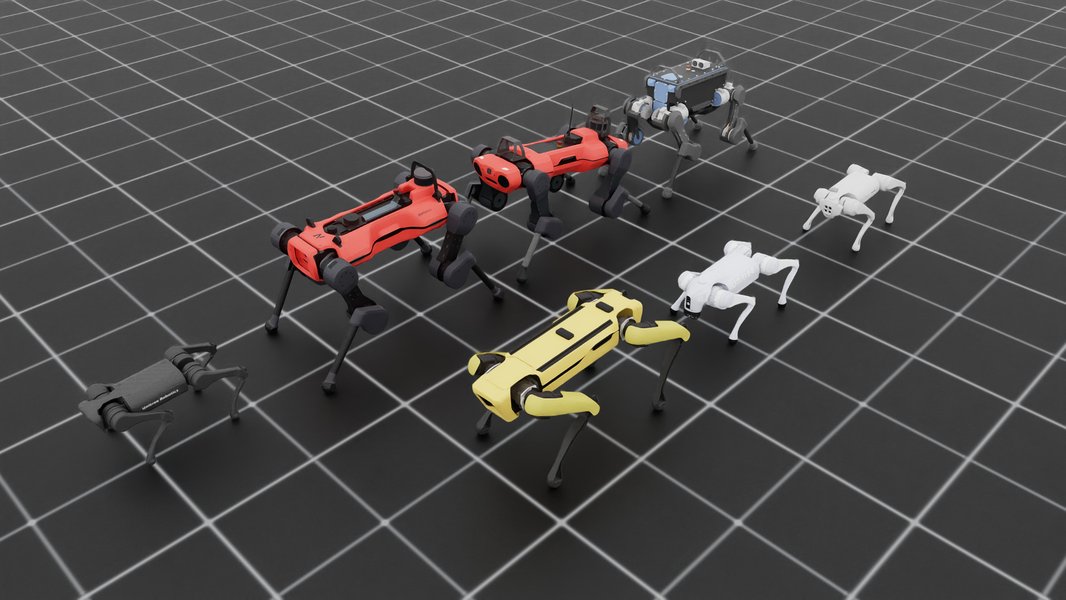

在机器人技术飞速发展的今天,四足机器人因其卓越的适应性和运动能力,在诸多领域展现出巨大潜力。NVIDIA Isaac Sim作为一款强大的机器人仿真和合成数据生成平台,为研究和开发高级机器人控制策略(尤其是基于强化学习的策略)提供了理想的环境。本教程将引导您了解如何在Isaac Sim中,结合强化学习(RL)技术,训练四足机器人掌握复杂的运动控制技能。

核心洞察与关键要点

在您开始之前,请把握以下核心内容:

- 核心平台与工具: 熟练掌握NVIDIA Isaac Sim、Isaac Lab以及OmniIsaacGymEnvs/IsaacGymEnvs等关键工具是成功训练四足机器人的基石。这些平台提供了逼真的物理仿真环境和高效的RL训练框架。

- 强化学习完整流程: 理解从环境搭建、机器人模型选择与导入、观测空间与动作空间定义、奖励函数设计,到RL算法选择(如PPO)、策略训练、以及最终的Sim-to-Real部署,这一完整流程至关重要。

- GPU加速与领域随机化: 充分利用NVIDIA GPU进行大规模并行仿真以显著加速训练过程,并通过领域随机化(Domain Randomization)技术增强训练出策略的鲁棒性和对真实世界环境的泛化能力。

基础准备:为您的四足机器人RL之旅奠定基础

在深入研究四足机器人运动控制的强化学习训练之前,确保您的开发环境已正确配置,并且具备必要的硬件支持。

硬件与软件要求

硬件配置

强化学习训练,尤其是在Isaac Sim这类高保真仿真环境中,对计算资源有较高要求。推荐配置如下:

- GPU: 强烈建议使用NVIDIA RTX系列显卡(如RTX 30系列、RTX 40系列或更高级别的专业卡),因为Isaac Sim和Isaac Lab的并行仿真及RL计算主要在GPU上完成,强大的GPU能显著缩短训练时间。

- CPU与内存: 高性能的多核CPU和充足的RAM(建议32GB或以上)也是流畅运行仿真和训练的保障。

软件安装与环境搭建

请遵循NVIDIA官方指南完成以下软件的安装与配置:

- NVIDIA Isaac Sim: 从NVIDIA官方网站下载并安装最新版本的Isaac Sim。它基于Omniverse平台,提供了核心的仿真能力。

- NVIDIA Isaac Lab: Isaac Lab是构建在Isaac Sim之上的一个轻量级参考应用,专门针对大规模机器人学习(特别是RL)进行了优化。请根据官方文档进行安装和设置。

- Python环境: 搭建一个独立的Python环境(推荐使用Conda或venv),并安装必要的RL库,如:

stable-baselines3: 一套流行的、可靠的强化学习算法实现。rl_games或RSL-RL: NVIDIA提供的、针对GPU优化的RL库,常用于Isaac Sim相关的项目中。

- CUDA与NVIDIA驱动: 确保安装了与您的GPU兼容的最新NVIDIA驱动程序和CUDA工具包。

- Git: 用于克隆示例代码仓库,如IsaacGymEnvs或OmniIsaacGymEnvs。

完成这些基础准备后,您就可以开始探索Isaac Sim中四足机器人的强化学习世界了。

NVIDIA Isaac Sim 平台提供强大的机器人仿真能力。

深入理解:四足机器人RL的核心概念

强化学习通过让智能体(Agent,即我们的四足机器人)在环境(Environment,即Isaac Sim中的仿真场景)中不断试错,并根据其行为获得奖励或惩罚,从而学习到最优策略(Policy)。

关键组成部分

- 观测空间 (Observation Space): 机器人能够感知到的环境信息和自身状态。对于四足机器人,这可能包括关节角度、关节速度、基座的线速度和角速度、足部接触力、以及目标指令(如期望速度)等。

- 动作空间 (Action Space): 机器人可以执行的动作。对于四足机器人,通常是12个自由度(每条腿3个关节)的目标关节位置、速度或力矩。

- 奖励函数 (Reward Function): 评价机器人在特定状态下执行某个动作后好坏程度的标量信号。精心设计的奖励函数是RL成功的关键,它需要引导机器人学习期望的行为,如稳定行走、跟踪目标速度、最小化能耗等。

- 强化学习算法:

- PPO (Proximal Policy Optimization): 一种常用且效果稳健的策略梯度算法,因其实现相对简单且性能良好,在机器人控制领域被广泛应用。NVIDIA的RSL-RL库对其有GPU优化实现。

- 其他算法如SAC (Soft Actor-Critic) 等也可用于特定任务。

- 领域随机化 (Domain Randomization): 在训练过程中,有意地随机化仿真环境的物理参数(如摩擦系数、物体质量、地面不平整度、传感器噪声等)。这有助于训练出更鲁棒的策略,提高其从仿真到真实机器人(Sim-to-Real)的迁移能力。

四足机器人如 Cheetah-Cub 是强化学习研究的常见对象。

核心工具与平台详解

NVIDIA提供了一套完整的工具链,用于在Isaac Sim中进行四足机器人的强化学习训练。

主要平台与框架

- NVIDIA Isaac Sim: 底层仿真平台,提供高保真度的物理引擎(PhysX 5)和渲染能力,能够精确模拟机器人与环境的交互。

- NVIDIA Isaac Lab: 专为机器人学习设计的框架,构建于Isaac Sim之上。它通过GPU加速并行化物理仿真,极大地提高了RL训练的样本采集效率和整体训练速度。

- OmniIsaacGymEnvs / IsaacGymEnvs: 这些是官方提供的GitHub仓库,包含了大量预设的强化学习环境示例,其中包括多种四足机器人(如ANYmal, Unitree A1/Go1/Go2, Spot)的步态控制任务。这些仓库是学习和开始RL训练的绝佳起点,提供了完整的训练脚本和环境配置文件。

IsaacGymEnvs: 较早期的版本,基于Isaac Gym。OmniIsaacGymEnvs: 较新的版本,与Isaac Sim更紧密集成,推荐使用。

- RSL-RL (Reinforcement Learning Games Library): NVIDIA开发的强化学习库,针对其硬件进行了优化,常与OmniIsaacGymEnvs结合使用,内置了高效的PPO实现。

下表总结了在Isaac Sim中进行四足机器人RL时常用的一些关键工具和库:

| 工具/库 (Tool/Library) | 描述 (Description) | 主要用途 (Main Purpose) | 备注 (Notes) |

|---|---|---|---|

| NVIDIA Isaac Sim | 基于Omniverse的机器人仿真和合成数据生成平台。 | 高保真物理仿真,机器人开发、测试和训练。 | 核心仿真环境。 |

| NVIDIA Isaac Lab | 构建在Isaac Sim之上,专为大规模机器人学习优化的轻量级参考应用。 | 加速RL训练,支持并行仿真。 | 推荐用于RL,提供高效训练框架。 |

| OmniIsaacGymEnvs | Isaac Sim中实现强化学习环境的示例仓库(新版)。 | 提供四足机器人等RL任务的预设环境和训练脚本。 | 重要的代码和示例来源,与Isaac Lab紧密集成。 |

| IsaacGymEnvs | Isaac Gym中实现强化学习环境的示例仓库(旧版)。 | 提供RL任务的预设环境和训练脚本。 | 仍有参考价值,但建议关注OmniIsaacGymEnvs。 |

| RSL-RL | NVIDIA的强化学习库,针对GPU优化。 | 高效的RL算法实现,常用于Isaac Sim项目。 | 与PPO算法结合使用效果佳。 |

| Stable-Baselines3 | 一套可靠的强化学习算法实现。 | 另一种流行的RL库选择,Isaac Lab提供Wrapper适配。 | 社区支持良好,易于上手。 |

| URDF/MJCF | 机器人模型描述格式。 | 定义机器人结构、关节、传感器等。 | 用于导入自定义或标准机器人模型。 |

四足机器人RL训练步骤详解

以下是在Isaac Sim中训练四足机器人进行运动控制的通用步骤:

1. 选择或自定义四足机器人模型

Isaac Sim和OmniIsaacGymEnvs提供了多种预设的四足机器人模型(如Unitree A1、ANYmal C)。您可以直接使用这些模型,或导入您自己的机器人模型(通常为URDF或MJCF格式)。确保模型文件正确描述了机器人的运动学和动力学特性。

Isaac Lab 支持多种四足机器人模型用于强化学习训练。

2. 配置RL环境与任务

在OmniIsaacGymEnvs或您自定义的项目中,您需要配置RL环境。这包括:

- 任务定义: 明确机器人的训练目标,例如跟踪特定的基座线速度(x,y)和偏航角速度(yaw)。

- 观测空间定义: 选择机器人状态和目标信息作为RL智能体的输入。

- 动作空间定义: 通常是机器人12个关节的目标位置或力矩。

- 奖励函数设计: 这是RL训练中最具挑战性的部分之一。奖励函数应激励机器人学习期望的步态,例如:

- 正向速度奖励

- 姿态稳定奖励(例如,保持躯干水平)

- 能量消耗惩罚

- 足部打滑或不期望的身体接触惩罚

- 命令跟踪奖励(如速度、方向)

- 仿真参数: 设置仿真环境的物理参数,如重力、地面摩擦力等。应用领域随机化来增强模型的泛化能力。

3. 启动强化学习训练脚本

使用OmniIsaacGymEnvs等框架提供的训练脚本(通常是Python脚本),例如针对PPO算法的脚本。通过命令行参数指定任务名称(如控制Unitree A1在平地上运动的任务)、环境数量(Isaac Lab支持大规模并行环境,如同时运行数百上千个仿真实例)以及其他训练超参数。

例如,一个典型的训练启动命令可能如下所示 (具体命令请参考您使用的框架文档):

# 示例命令,具体请查阅相关文档

python train.py --task=AnymalTerrain --num_envs=4096 --headless

--headless 参数表示在无图形界面的模式下运行训练,可以显著提高训练速度。训练过程中,策略网络(通常是一个多层感知器MLP)的参数会不断更新。

4. 监控训练过程与评估

训练过程中,您需要监控关键指标,如平均回合奖励、策略损失、价值函数损失等,以判断训练是否收敛以及策略性能是否提升。大多数RL框架都集成了TensorBoard等可视化工具,方便您实时跟踪这些指标。

训练开始时,机器人往往无法站稳或行走,甚至会做出怪异的动作。随着训练的进行(通常需要数百万到数千万个时间步,对应数小时到数天的训练时间,具体取决于任务复杂度和硬件性能),机器人会逐渐学会稳定的行走策略。

5. 策略部署与测试

训练完成后,保存学到的策略模型(通常是神经网络的权重)。您可以在Isaac Sim中加载这个训练好的策略,并在新的或不同的仿真环境中测试其性能,评估其鲁棒性和泛化能力。例如,测试其在不同地形、不同速度指令下的表现。

Sim-to-Real 迁移

将仿真中训练好的策略部署到真实的四足机器人上是最终目标。Isaac Sim和Isaac Lab通过高保真物理仿真和领域随机化技术,致力于缩小仿真与现实之间的差距(Sim-to-Real Gap)。尽管如此,直接部署时仍可能需要进行一些微调(fine-tuning)或领域适应(domain adaptation)操作。NVIDIA提供了一些关于如何将Isaac Lab中训练的策略部署到真实四足机器人(如Spot)的指南和博客。

强化学习算法性能比较 (示例)

不同的强化学习算法在四足机器人运动控制任务中表现各异。以下雷达图基于一般认知,对几种常见方法在关键性能维度上进行了概念性的比较。实际表现会因具体实现、任务和超参数调优而有所不同。

此雷达图提供了一个高级视角,帮助您理解不同RL方法在应用于四足机器人时的潜在权衡。例如,PPO通常以其稳健性和相对简单的实现而受到青睐;SAC可能在样本效率和探索方面表现更好;而基于模型的RL方法理论上样本效率最高,但实现复杂且模型准确性是关键。

四足机器人RL训练流程概览

下图通过思维导图的形式,直观地展示了在Isaac Sim中进行四足机器人强化学习运动控制的主要环节和相互关系,帮助您构建一个清晰的整体认知框架。

惩罚不良行为"] id2_4["RL算法 (RL Algorithms)"] id2_4_1["PPO (Proximal Policy Optimization)"] id2_4_2["SAC (Soft Actor-Critic)"] id2_5["领域随机化 (Domain Randomization)"] id3["关键工具与平台 (Key Tools & Platforms)"] id3_1["NVIDIA Isaac Sim"] id3_2["NVIDIA Isaac Lab"] id3_3["OmniIsaacGymEnvs / IsaacGymEnvs"] id3_3_1["预设环境与示例"] id3_4["RL训练库 (RSL-RL, SB3)"] id4["训练工作流 (Training Workflow)"] id4_1["选择/导入机器人模型 (Select/Import Robot Model)"] id4_1_1["URDF / MJCF 格式"] id4_1_2["Unitree A1, ANYmal等"] id4_2["配置RL任务与环境 (Configure RL Task & Environment)"] id4_3["运行训练脚本 (Run Training Script)"] id4_3_1["GPU并行加速 (GPU Parallel Acceleration)"] id4_3_2["Headless 模式"] id4_4["监控与评估 (Monitor & Evaluate)"] id4_4_1["TensorBoard 可视化"] id4_4_2["检查收敛性"] id4_5["策略保存与加载 (Policy Saving & Loading)"] id5["Sim-to-Real 迁移 (Sim-to-Real Transfer)"] id5_1["弥合仿真与现实差距 (Bridging the Sim-to-Real Gap)"] id5_2["真实机器人部署考量 (Real Robot Deployment Considerations)"] id5_3["策略微调 (Policy Fine-tuning)"] id6["资源与学习 (Resources & Learning)"] id6_1["NVIDIA官方文档 (Official Documentation)"] id6_2["GitHub 仓库 (GitHub Repositories)"] id6_3["社区教程与论坛 (Community Tutorials & Forums)"] id6_4["研究论文 (Research Papers)"]

这个思维导图概括了从初始设置到最终部署的整个过程,强调了各个组成部分的重要性以及它们之间的联系。掌握这些环节将有助于您系统地开展四足机器人RL项目。

视频教程:实战演示

观看以下视频教程,可以更直观地了解如何在Isaac Lab中训练自定义四足机器人行走。这类实操演示对于理解具体步骤和可能遇到的问题非常有帮助。

视频教程:如何使用Isaac Lab训练自定义四足机器人行走 (来源: YouTube - robot mania)

该视频展示了使用Isaac Lab训练自定义四足机器人的过程。通常这类教程会涵盖环境配置、机器人模型导入、RL任务设置、训练脚本运行以及结果观察等关键步骤。通过观看实际操作,您可以对整个流程有更具体的认识,并学习到一些实用的技巧和故障排除方法。例如,视频可能会展示如何调整奖励函数以获得更好的行走姿态,或者如何解读TensorBoard中的训练曲线。

常见问题解答 (FAQ)

在Isaac Sim中训练四足机器人对硬件有什么要求?

PPO是唯一可以使用的强化学习算法吗?

如何提高训练模型的Sim-to-Real泛化能力?

在哪里可以找到Isaac Sim四足机器人RL的示例代码?

训练一个四足机器人走路大概需要多长时间?

推荐探索

如果您希望进一步深入学习,以下是一些相关的探索方向:

- 如何在Isaac Sim中自定义四足机器人模型并进行强化学习训练?

- 探索Isaac Sim中用于Sim-to-Real迁移的领域随机化高级技巧。

- 比较不同强化学习算法在Isaac Sim四足机器人步态控制中的性能。

- 了解在Isaac Sim中为四足机器人设计有效奖励函数的最佳实践。

参考资料

以下是本教程内容参考的一些重要资源链接:

Last updated May 19, 2025