解锁 KAN 潜力:精确控制输出范围与有效抑制过拟合

深入探讨如何将 Kolmogorov-Arnold 网络 (KAN) 的输出约束在 [0, 1] 区间,并掌握降低其过拟合风险的关键策略。

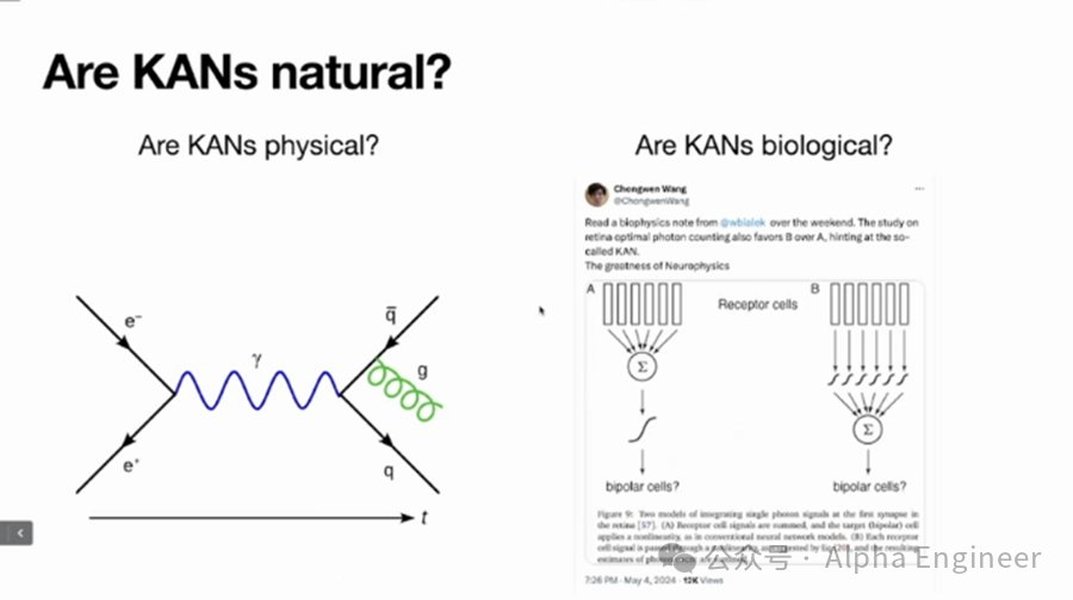

Kolmogorov-Arnold 网络 (KAN) 作为一种新兴的神经网络架构,其灵感来源于 Kolmogorov-Arnold 表示定理。与传统的多层感知机 (MLP) 在节点上使用固定激活函数不同,KAN 创新地在网络的“边”(连接)上使用了可学习的单变量函数(通常参数化为 B 样条)。这种独特设计赋予了 KAN 在函数逼近、可解释性和参数效率方面的巨大潜力。然而,在实际应用中,我们常常需要精确控制模型的输出范围,并有效防止模型过拟合。本文将详细探讨如何实现这两个目标。

核心要点速览

- 输出范围控制: 最常用且直接的方法是在 KAN 网络的最终输出层后添加一个 Sigmoid 激活函数,将任意实数输出映射到 (0, 1) 区间。

- KAN 特定过拟合抑制: 利用 L1 正则化和熵正则化促进模型稀疏性,结合训练后的网络剪枝 (Pruning),移除冗余函数边,是 KAN 独特的抗过拟合机制。

- 通用过拟合抑制: 传统的数据增强、早停法 (Early Stopping)、交叉验证以及合理控制模型复杂度(如调整网络层级、节点数或样条参数)对 KAN 同样有效。

精确控制 KAN 输出范围:确保结果在 [0, 1] 之间

为何需要限制输出?

在许多机器学习任务中,如二元分类(输出概率)、概率密度估计或需要归一化输出的回归问题,模型的输出必须被限制在特定的范围,最常见的便是 [0, 1] 区间。KAN 的核心是边上的可学习函数(如 B 样条),它们的组合输出值理论上可以是任意实数,因此需要额外的机制来确保输出符合要求。

实现输出范围 [0, 1] 的策略

1. 输出层应用 Sigmoid 激活函数

这是最直接且广泛采用的方法。在 KAN 网络的最后一层计算得到最终输出值后,应用 Sigmoid 函数进行变换。Sigmoid 函数的数学表达式为:

\[ \sigma(x) = \frac{1}{1 + e^{-x}} \]该函数能将任何实数输入 \(x\) 平滑地映射到 (0, 1) 开区间内。这与传统神经网络处理类似问题的做法一致,并且不影响 KAN 内部的可学习函数机制。

实现思路: 在模型定义时,在 KAN 主体结构之后添加一个 Sigmoid 层。例如,在 PyTorch 等框架中:

# 概念性示例代码

import torch

import torch.nn as nn

# 假设 KAN_Layer 是已实现的 KAN 层

# from kan_module import KAN_Layer

class KAN_with_SigmoidOutput(nn.Module):

def __init__(self, kan_config):

super().__init__()

# 初始化 KAN 层 (根据具体实现传入配置)

self.kan_core = KAN_Layer(kan_config)

# 添加 Sigmoid 激活层

self.output_activation = nn.Sigmoid()

def forward(self, x):

# 通过 KAN 核心网络

kan_output = self.kan_core(x)

# 应用 Sigmoid 函数限制输出

final_output = self.output_activation(kan_output)

return final_output

# 使用示例

# config = {'width': [input_dim, hidden_dim1, hidden_dim2, 1], 'grid': 5, 'k': 3}

# model = KAN_with_SigmoidOutput(kan_config=config)

# input_data = torch.randn(batch_size, input_dim)

# output = model(input_data) # output 值将在 (0, 1) 范围内

优点: 实现简单,效果明确,是标准实践。

注意事项: 添加 Sigmoid 后,需要配合适当的损失函数,如二元交叉熵损失 (Binary Cross-Entropy Loss),尤其是在二分类任务中。同时,需关注其对梯度传播可能带来的影响(如梯度消失问题),并适当调整学习率或优化器。

2. 设计具有内在边界的边函数

理论上,可以设计或约束 KAN 边上的可学习函数(如 B 样条),使其输出本身就在一个有限范围内。例如,可以修改样条基函数或约束其控制点,使得每个边函数的输出值被限制,从而间接影响最终输出范围。或者在函数定义中加入类似 Sigmoid 或 Tanh 的压缩函数。

优点: 从根本上控制函数行为。

缺点: 实现更复杂,可能影响模型的表达能力和训练动态。目前在主流 KAN 实现中较少见。

3. 输出后处理:归一化或裁剪

如果不想修改模型结构,可以在得到 KAN 的原始输出后,再进行处理。

- Min-Max 归一化: 如果输出是一个向量,可以计算其最小值 (min) 和最大值 (max),然后通过 \(\frac{\text{output} - \min}{\max - \min}\) 将其缩放到 [0, 1]。但这依赖于批次数据或整个数据集的范围。

- 裁剪 (Clipping): 直接将小于 0 的输出设置为 0,大于 1 的输出设置为 1。这种方法比较“硬”,可能丢失信息。

优点: 不改变模型训练过程。

缺点: 属于后处理,可能不如在模型结构中解决来得优雅和有效,尤其裁剪可能引入偏差。

降低 KAN 过拟合风险:提升模型泛化能力

过拟合是指模型在训练数据上表现优异,但在未见过的新数据(测试集或验证集)上表现不佳的现象。尽管 KAN 可能比传统 MLP 更具参数效率,但当模型复杂度过高或训练数据不足时,仍然会面临过拟合的风险。幸运的是,结合 KAN 的特性和通用的深度学习技术,我们可以采取多种策略来缓解过拟合。

KAN 网络结构示意图,展示了边上的可学习函数。

KAN 特有的正则化与剪枝策略

1. L1 正则化与熵正则化

这是 KAN 中抑制过拟合和提升可解释性的关键技术。

- L1 正则化: 通过在损失函数中添加边函数参数(或其某种度量,如基于权重的 L1 范数)的 L1 范数惩罚项,鼓励模型参数趋向于零。这会导致许多边上的函数变得“平坦”或接近零,从而实现模型的稀疏化。稀疏的模型更简单,更不容易拟合训练数据中的噪声。

- 熵正则化: 有些 KAN 实现还引入熵正则化,旨在鼓励函数激活的稀疏性或均匀性,进一步抑制冗余连接,简化模型。

实现: 在计算总损失时加入正则化项:

\[ \text{Total Loss} = \text{Original Loss} + \lambda_1 \times \text{L1 Regularization Term} + \lambda_{entropy} \times \text{Entropy Regularization Term} \]其中 \(\lambda_1\) 和 \(\lambda_{entropy}\) 是需要调整的超参数,控制正则化的强度。

2. 网络剪枝 (Pruning)

得益于 L1 等正则化带来的稀疏性,可以在训练后或训练过程中识别并移除对模型贡献很小的边(即其上的函数影响微弱)。这直接降低了模型的复杂度。

实现: 一些 KAN 库提供了自动剪枝的功能。通常基于训练后各边函数的重要性(例如,通过其系数的大小或对输出的影响来衡量)进行判断,移除低于某个阈值的边。

优点: 直接简化模型,提高推理效率,并有助于防止过拟合。

KAN 与传统 MLP 的结构对比,突显 KAN 在边上学习函数的特点。

通用的深度学习抗过拟合技术

1. 增加数据量与数据增强

- 更多数据: 获取更多样化的训练数据是防止过拟合最根本有效的方法之一。

- 数据增强 (Data Augmentation): 对现有数据进行变换(如图像的旋转、平移、缩放、颜色抖动;或对表格数据添加噪声、特征组合等)来人工扩充数据集。这能提高模型对数据变化的鲁棒性。

2. 早停法 (Early Stopping)

在训练过程中,持续监控模型在独立验证集上的性能(如损失或准确率)。当验证集性能不再提升甚至开始下降时,即使训练集损失仍在降低,也应停止训练。这可以防止模型在训练后期过度拟合训练数据。

3. 交叉验证 (Cross-Validation)

将训练数据划分为多个折叠(folds),轮流使用一部分作为验证集,其余作为训练集。这有助于更可靠地评估模型性能和选择超参数(如正则化强度、学习率、网络结构),减少因单次划分验证集带来的偶然性。

4. 控制模型复杂度

如果模型过于复杂,就容易过拟合。可以尝试:

- 减少网络层数或宽度: 使用更少的隐藏层或每层更少的节点(在 KAN 中对应 `width` 参数)。

- 降低边函数的复杂度: 减少样条的网格点数 (`grid` 参数) 或多项式阶数 (`k` 参数)。

需要通过实验找到复杂度和性能之间的平衡点。

5. L2 正则化

除了 L1,也可以使用 L2 正则化(权重衰减),它惩罚较大的参数值,倾向于使参数分布更平滑,也能在一定程度上防止过拟合。

6. Dropout 与 Batch Normalization (适用性待考)

虽然 Dropout(随机失活神经元)和 Batch Normalization(批归一化)是 MLP 中常用的正则化手段,它们在 KAN 架构中的直接适用性和效果可能需要进一步研究和调整,因为 KAN 的计算方式与 MLP 不同。但借鉴其思想,引入随机性或标准化层可能也是探索的方向。

7. 优化算法与初始化

选择合适的优化器(如 Adam、LBFGS,后者在一些 KAN 研究中被提及)和良好的参数初始化策略,有助于模型收敛到更优的、泛化能力更强的解。

KAN 过拟合抑制策略效果评估

为了直观比较不同抗过拟合策略在 KAN 中的潜在效果,我们可以使用雷达图进行展示。请注意,这里的评分是基于当前普遍理解和研究文献的定性评估,实际效果可能因具体任务和数据而异。

上图评估了各项策略的抗过拟合效果(普遍有效性)以及它们与 KAN 架构的特异性或相关程度。可见,L1 正则化、熵正则化和剪枝是与 KAN 结构结合紧密的有效手段,而数据增强和早停法作为通用策略,效果也非常显著。

KAN 优化策略概览:思维导图

下面的思维导图总结了本文讨论的关于 KAN 输出限制和过拟合抑制的主要方法。

此思维导图清晰地展示了针对 KAN 输出限制和过拟合问题的两大类解决方案及其下的具体技术分支。

方法总结对比表

下表总结了讨论过的方法及其关键特性:

| 目标 | 方法 | 机制 | 优点 | 缺点/注意事项 | KAN 相关性 |

|---|---|---|---|---|---|

| 输出限制 [0, 1] | Sigmoid 输出层 | 非线性激活函数压缩输出 | 简单、标准、有效 | 可能影响梯度,需配合损失函数 | 高 (通用,易于添加) |

| 有界边函数 | 约束样条或其他函数形式 | 从根本上限制 | 理论上更内在 | 实现复杂,可能影响表达力 | 中 (需要修改 KAN 核心) |

| 后处理 | Min-Max 归一化 / 裁剪 | 对最终结果进行变换 | 不改模型 | 可能引入偏差或依赖数据范围 | 低 (通用后处理) |

| 降低过拟合 | L1 正则化 | 惩罚参数绝对值,促稀疏 | 简化模型、提高可解释性 | 需要调超参 \(\lambda_1\) | 非常高 (KAN 核心机制) |

| 熵正则化 | 鼓励激活稀疏/均匀 | 进一步简化、抑制冗余 | 需要调超参 \(\lambda_{entropy}\) | 高 (常与 L1 结合) | |

| 网络剪枝 | 移除低贡献函数边 | 直接降低复杂度、提效 | 依赖于正则化效果和剪枝策略 | 非常高 (KAN 的优势之一) | |

| 数据增强 | 扩充训练数据多样性 | 提高模型鲁棒性 | 需要设计合适的增强方法 | 中 (通用) | |

| 早停法 | 监控验证集性能,适时停止 | 防止过度训练 | 需要独立的验证集 | 中 (通用) | |

| 控制模型复杂度 | 调整网络/函数参数 | 使用更简单的模型 | 直接有效 | 可能导致欠拟合,需权衡 | 高 (调整 KAN 特定参数) |

| L2 正则化 | 惩罚参数平方和 | 平滑参数,防止过大值 | 常用正则化手段 | 效果可能不如 L1 对稀疏性贡献大 | 中 (通用) |

通过结合使用上述策略,特别是 KAN 特有的正则化和剪枝方法,以及通用的数据和训练技巧,可以有效地将 KAN 应用于需要 [0, 1] 输出范围的任务,并显著提升其泛化能力,避免过拟合。

常见问题解答 (FAQ)

为什么需要将 KAN 的输出限制在 [0, 1] 范围内?

除了 Sigmoid 函数,还有其他方法可以将输出限制到 [0, 1] 吗?

KAN 中的稀疏化(通过 L1 正则化和剪枝)如何帮助减少过拟合?

相比传统 MLP,KAN 是否天生更不容易过拟合?

参考文献

- KAN: Kolmogorov-Arnold Networks - arXiv

- 深入理解 Kolmogorov-Arnold Networks (KAN) - CSDN博客

- Efficient KAN PyTorch Implementation - Dong AIGC

- KAN:Kolmogorov–Arnold Networks 原创 - CSDN博客

- 让神经网络回归理论极限,KAN到底是什么? - 知乎专栏

- KAN 一作刘子鸣直播总结:KAN的能力边界和待解决的问题 - BAII Hub

推荐探索

Last updated April 23, 2025