释放Linux潜能:终极内核优化指南

深入探索Linux内核调优的奥秘,全面提升系统性能、稳定性与效率。

Linux内核作为操作系统的核心,其性能直接影响着整个系统的表现。通过精心的优化,可以显著提升应用程序的响应速度、数据处理能力以及系统的整体稳定性。本指南将全面介绍Linux内核优化的关键策略与实践方法,助您根据特定需求打造高效的Linux环境。

核心洞察:三大优化支柱

- 精细化参数调整: 通过

sysctl和/proc文件系统,动态调整内核参数是优化CPU调度、内存管理、网络栈和文件系统行为,以适应特定工作负载的基础。 - 定制化内核编译: 针对特定硬件和应用需求编译内核,移除不必要的模块,启用针对性优化,可以最大限度地提升效率和减少资源占用。

- 持续监控与验证: 任何优化都离不开有效的监控与基准测试。利用专业工具跟踪系统性能指标,是验证优化效果、发现潜在瓶颈的关键。

理解Linux内核:优化的基石

Linux内核是操作系统的核心组件,负责管理系统的硬件资源(如CPU、内存、磁盘I/O)和软件资源(如进程调度、网络通信)。它提供了一系列接口供应用程序与硬件交互。理解内核的基本工作原理,例如其模块化设计(允许通过加载或卸载模块来扩展功能),是进行有效优化的前提。不同版本的内核可能包含不同的特性、优化和硬件支持。

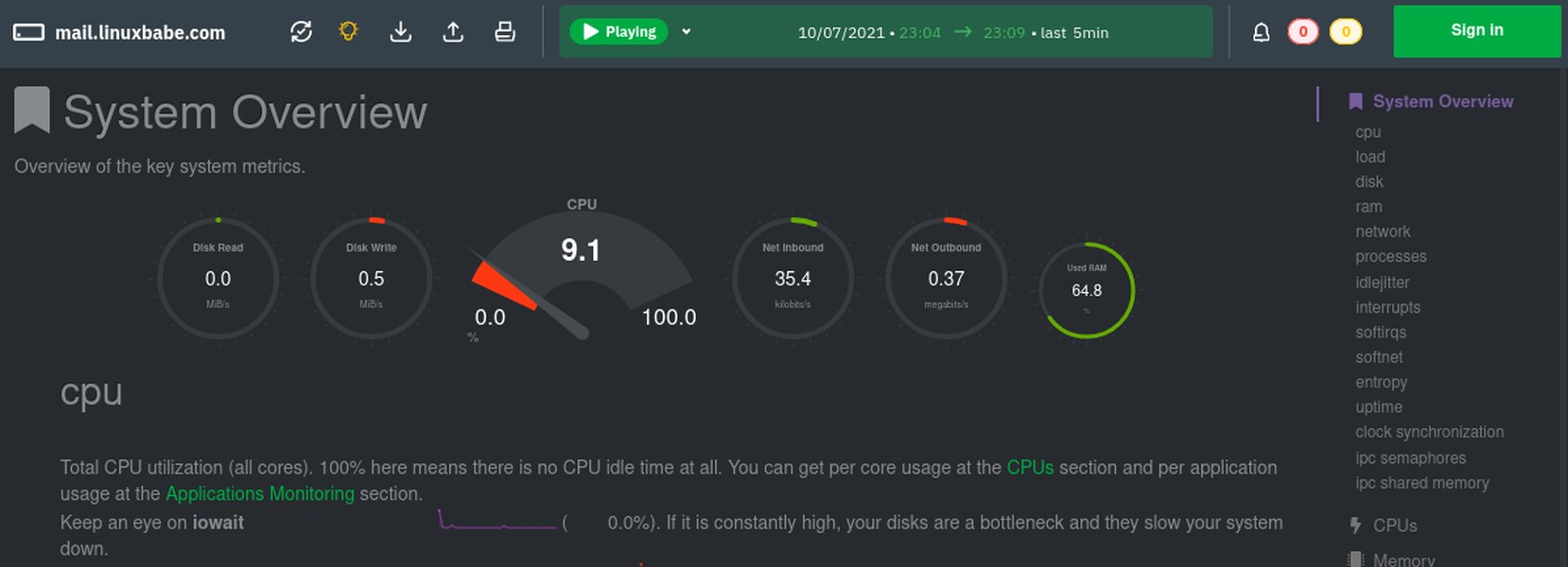

一个典型的Linux系统监控仪表盘,展示关键性能指标。

选择合适的内核版本

选择正确的内核版本对于系统性能、稳定性和安全性至关重要。不同的应用场景可能需要不同类型的内核:

- 长期支持版 (LTS - Long-Term Support) 内核: 专为服务器、企业和生产环境设计,提供长期的安全更新和高度的稳定性。它们是追求可靠性的首选。

- 主线版 (Mainline) 内核: 包含了最新的功能、硬件支持和性能改进。虽然可能不如LTS版本稳定,但适合希望尝试最新技术的用户或需要特定新硬件支持的场景。

- 实时版 (Real-time) 内核: 针对需要低延迟和确定性响应的应用进行了特殊优化,例如工业控制系统、金融交易平台或高质量多媒体处理。通常通过应用 PREEMPT_RT 补丁集实现。

您可以使用以下命令检查当前运行的Linux内核版本:

uname -r根据您的具体需求(例如,服务器稳定性、桌面最新特性、嵌入式实时性),选择最合适的内核分支和版本是优化的第一步。

内核参数调优:动态提升系统效能

调整内核参数是Linux性能优化中最常用且效果显著的方法之一。通过 sysctl 工具或直接修改 /proc 文件系统中的文件,可以动态地改变内核的运行时行为,而无需重新编译内核或重启系统(大部分参数如此)。

通过 sysctl 和 /proc 进行动态调整

sysctl 命令用于在运行时读取和修改内核参数。这些参数通常位于 /proc/sys/ 目录下。例如,要临时更改一个参数:

sysctl -w vm.swappiness=10要使更改永久生效,应将参数配置写入 /etc/sysctl.conf 文件或 /etc/sysctl.d/ 目录下的配置文件中,然后执行 sysctl -p 或 sysctl --system 加载配置。

CPU调度优化

CPU调度器负责决定哪个进程在何时以及在哪个CPU核心上运行。调整调度器参数可以改善CPU效率和应用响应性。

kernel.sched_min_granularity_ns:任务在被抢占前可以运行的最小时间。较低的值可能提高交互应用的响应速度,但会增加上下文切换的开销。kernel.sched_wakeup_granularity_ns:一个任务唤醒后,需要等待多久才能抢占当前运行的任务。

内存管理优化

有效的内存管理对于系统性能至关重要。不当的配置可能导致过多的交换(swapping)或内存不足。

vm.swappiness:控制内核将内存页换出到交换空间的倾向性。值的范围是0到100。较低的值(如10)使内核更倾向于保留数据在物理内存中,适合内存充足的系统或对延迟敏感的应用。默认值通常是60。vm.dirty_ratio:当脏页(已修改但未写入磁盘的内存页)占总可用内存的百分比达到此值时,系统会强制进程同步将脏页写入磁盘。vm.dirty_background_ratio:当脏页占总可用内存的百分比达到此值时,内核的后台刷新进程(如pdflush或kworker)会开始异步将脏页写入磁盘。vm.vfs_cache_pressure:控制内核回收用于目录和inode对象缓存的内存的倾向。默认值100,增加此值使内核更积极地回收inode和dentry缓存。

网络栈优化

对于网络密集型应用,特别是高并发服务器,优化TCP/IP栈参数至关重要。

net.core.somaxconn:定义了TCP监听队列的最大长度。对于高并发Web服务器,建议将其值调高(例如,从默认的128增加到1024或更高,甚至65535)。net.ipv4.tcp_max_syn_backlog:定义了处于SYN_RECV状态的TCP连接的最大数量。增加此值有助于应对SYN洪水攻击和高连接率。net.ipv4.tcp_tw_reuse:设置为1时,允许将TIME-WAIT状态的套接字重新用于新的TCP连接,有助于在高连接率的短连接场景下减少端口耗尽问题。net.ipv4.tcp_fin_timeout:定义了套接字在FIN-WAIT-2状态下保持的时间。减少此值可以更快地释放资源。net.core.netdev_max_backlog:当网络接口接收数据包的速度快于内核处理它们的速度时,允许排队的数据包的最大数量。net.ipv4.tcp_rmem和net.ipv4.tcp_wmem:分别设置TCP接收和发送缓冲区的最小、默认和最大值。调整这些值可以优化网络吞吐量。

文件系统参数优化

文件系统相关的参数调整可以优化磁盘I/O性能。

- 挂载选项

noatime:在挂载文件系统时使用此选项可以禁止更新文件的访问时间戳,从而减少不必要的磁盘写操作,对读取密集型负载有益。通过修改/etc/fstab实现。 fs.file-max:系统级别可以打开的文件句柄的最大数量。对于需要同时处理大量文件的服务器(如Web服务器或数据库),可能需要增加此值。

常用内核参数调优汇总表

下表总结了一些常见的内核参数及其优化目标,这些参数通常通过 sysctl 进行调整。请注意,最佳值取决于具体的硬件配置和工作负载。

| 参数 (Parameter) | 描述 (Description) | 常见建议值/范围 (Common Recommended Value/Range) |

|---|---|---|

vm.swappiness |

控制系统使用交换空间的倾向性。值越低,越倾向于使用物理内存。 | 0-10 (对于内存充足的服务器) |

vm.dirty_ratio |

系统脏数据达到总可用内存此百分比时,触发同步写操作。 | 10-20% |

vm.dirty_background_ratio |

系统脏数据达到总可用内存此百分比时,后台进程开始异步写操作。 | 5-10% |

net.core.somaxconn |

TCP监听队列的最大长度,用于高并发服务器。 | 1024 - 65535 |

net.ipv4.tcp_max_syn_backlog |

SYN队列的最大长度,防止SYN洪水攻击。 | 2048 - 8192 或更高 |

net.ipv4.tcp_tw_reuse |

允许重用TIME_WAIT状态的套接字。 | 1 (启用) |

net.ipv4.ip_local_port_range |

允许本地TCP/UDP使用的端口范围。 | 例如 "1024 65535" |

kernel.sched_min_granularity_ns |

CPU调度器中任务运行的最小时间片(纳秒)。 | 根据负载调整 (例如 10000000) |

kernel.sched_wakeup_granularity_ns |

唤醒抢占的粒度(纳秒)。 | 根据负载调整 (例如 15000000) |

net.core.netdev_max_backlog |

网络设备接收数据包队列的最大长度。 | 1000 - 30000 |

fs.file-max |

系统级别最大打开文件句柄数。 | 例如 2097152 (根据需求调整) |

fs.inotify.max_user_watches |

用户可以创建的inotify watch的最大数量。 | 例如 524288 (对于IDE或文件监控工具) |

重要提示: 在修改任何参数之前,务必了解其含义和潜在影响。建议在测试环境中进行更改,并逐步调整,同时监控系统性能。

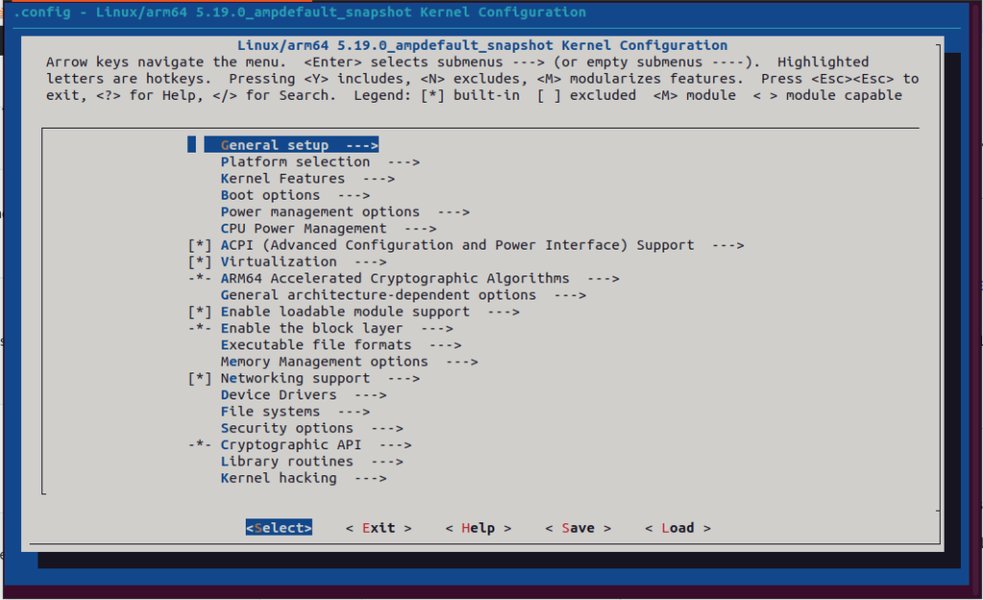

编译定制内核:深度优化之道

对于追求极致性能或有特定硬件需求的高级用户,从源代码编译内核提供了无与伦比的定制化能力。这允许您精确控制内核包含哪些功能、驱动程序和优化选项。

为何选择定制内核?

- 移除不必要的功能和驱动程序: 默认的发行版内核为了兼容性通常包含大量驱动和功能。移除系统中用不到的部分可以减小内核体积,减少内存占用,缩短启动时间,并可能提高系统整体效率和安全性(减少攻击面)。

- 针对特定处理器优化: 内核编译配置允许选择特定的CPU家族和型号,从而启用针对该架构的微调优化,如特定的指令集支持。

- 启用实验性或特定功能: 某些高级功能、最新的硬件驱动或特定的内核补丁可能未包含在标准发行版内核中,需要通过定制编译来启用。

- 精细调整内核选项: 数千个配置选项(通过

make menuconfig等工具访问)允许对内核的各个子系统进行细致调整。

使用 make menuconfig 配置Linux内核选项的界面示例。

编译步骤概览

编译定制内核通常涉及以下步骤:

- 安装必要的构建工具: 包括编译器(如 GCC)、make、ncurses-devel(用于 menuconfig)等。具体包名因发行版而异(如

build-essential,kernel-devel)。 - 获取内核源代码: 可以从官方网站 kernel.org 下载,或使用发行版提供的源码包。

# 例如,克隆稳定版内核源码 git clone https://git.kernel.org/pub/scm/linux/kernel/git/stable/linux.git - 配置内核选项: 这是最关键的一步。可以基于当前系统的配置(通常在

/boot/config-$(uname -r)),然后使用以下任一命令进行修改:make menuconfig: 基于文本的菜单界面。make nconfig: 类似于 menuconfig,但界面稍有不同。make xconfig: 基于 Qt 的图形界面。make gconfig: 基于 GTK 的图形界面。

- 编译内核:

make -j$(nproc) # 使用所有可用的CPU核心并行编译 - 安装模块:

sudo make modules_install - 安装内核:

此步骤通常会将编译好的内核映像 (sudo make installvmlinuz-*)、初始RAM盘 (initramfs-*) 和 System.map 文件复制到/boot目录,并更新引导加载程序(如 GRUB)的配置。 - 更新引导加载程序(如果需要): 某些系统在

make install后会自动更新引导加载程序。如果未自动更新,您可能需要手动运行如sudo update-grub(Debian/Ubuntu) 或sudo grub2-mkconfig -o /boot/grub2/grub.cfg(Fedora/RHEL)。 - 重启系统: 选择新编译的内核启动。

注意: 内核编译是一个复杂且耗时的过程。错误的配置可能导致系统无法启动或不稳定。务必在开始前备份重要数据,并充分了解您所修改的配置选项的含义。

I/O调度器优化

I/O调度器负责决定块设备(如硬盘、SSD)上的读写请求的顺序。选择合适的I/O调度器可以显著影响磁盘性能,尤其是在特定工作负载下。

常见的I/O调度器包括:

- noop (No Operation): 最简单的调度器,将所有I/O请求以FIFO(先进先出)的方式合并后直接传递给硬件。适用于没有寻道开销的设备(如SSD、NVMe)或底层已有智能调度(如虚拟化环境中的hypervisor)。

- deadline: 为每个请求设置一个截止时间,尝试在截止时间前完成请求。它优先处理读请求,以减少读延迟,适用于数据库等对读延迟敏感的应用。

- cfq (Completely Fair Queuing): 默认的调度器(在较旧的内核版本中)。它为每个进程维护一个I/O队列,并尝试在这些队列之间公平地分配I/O带宽。适用于桌面系统和混合工作负载。对于SSD,通常不推荐使用CFQ。

- bfq (Budget Fair Queuing): 基于CFQ改进,旨在为交互式应用提供更好的响应时间和更低的延迟,同时保证吞吐量。在较新的内核中,BFQ有时会取代CFQ成为默认调度器。

- kyber: 一个较新的多队列调度器,设计用于现代快速存储设备(如NVMe SSDs),旨在提供低延迟。

查看当前块设备的I/O调度器(以 sda为例):

cat /sys/block/sda/queue/scheduler输出会显示当前激活的调度器(用方括号括起)以及可用的调度器。例如:[mq-deadline] kyber bfq none。

临时更改I/O调度器(以将 sda 的调度器更改为 kyber 为例):

echo kyber | sudo tee /sys/block/sda/queue/scheduler要永久更改,通常需要通过udev规则或启动脚本进行设置。选择哪种调度器取决于您的存储设备类型和主要工作负载。对于SSD和NVMe设备,通常推荐使用 noop、mq-deadline 或 kyber。进行基准测试是确定最佳选择的有效方法。

CPU与中断优化

优化CPU使用和中断处理可以提高系统响应速度和多核处理效率。

CPU亲和性 (CPU Affinity)

CPU亲和性允许将特定进程或线程绑定到一个或一组特定的CPU核心上运行。这可以带来以下好处:

- 改善缓存命中率: 当一个进程始终在同一个CPU核心上运行时,其数据更有可能保留在该核心的缓存中,从而减少缓存未命中和内存访问延迟。

- 减少任务迁移开销: 避免进程在不同核心之间频繁迁移,减少上下文切换的成本。

- 隔离关键任务: 将性能敏感的任务绑定到专用核心,避免其他非关键任务的干扰。

可以使用 taskset 命令来设置或查看进程的CPU亲和性。例如,将进程ID为 <PID> 的进程绑定到CPU核心0和1:

sudo taskset -pc 0,1 <PID>中断绑定 (IRQ Affinity)

中断请求(IRQ)是硬件设备(如网卡、磁盘控制器)通知CPU需要处理事件的方式。默认情况下,中断可能由系统中的任何CPU核心处理。通过IRQ亲和性,可以将特定设备的中断处理绑定到特定的CPU核心或核心组。

这样做的好处类似于CPU亲和性,特别是对于高I/O负载的设备(如高速网卡):

- 提高网络吞吐量和降低延迟: 将网卡的中断处理绑定到特定的核心,可以避免中断处理在多个核心间切换,提高处理效率。

- 避免CPU核心过载: 将中断分散到不同的核心,防止单个核心因处理过多中断而成为瓶颈。

IRQ亲和性通常通过修改 /proc/irq/<IRQ_NUMBER>/smp_affinity 或 /proc/irq/<IRQ_NUMBER>/smp_affinity_list 文件来实现。例如,要将IRQ号为 <IRQ_NUM> 的中断绑定到CPU核心2(对应掩码为 4,即 22):

echo 4 | sudo tee /proc/irq/<IRQ_NUM>/smp_affinity或者使用列表格式指定核心2和3:

echo 2-3 | sudo tee /proc/irq/<IRQ_NUM>/smp_affinity_list确定哪些中断对应哪些设备,以及如何最佳分配它们,需要对系统硬件和工作负载有深入了解。工具如 irqbalance 可以自动在CPU核心间平衡IRQ,但手动调整有时能获得更优效果。

Linux内核优化关键因素雷达图

以下雷达图展示了Linux内核优化的几个关键领域,以及它们对系统性能的潜在影响力和实施的相对复杂度。评分是基于一般情况的主观评估,具体情况可能因系统和工作负载而异。“影响力评分”越高表示对性能提升的潜力越大,“复杂度评分”越高表示实施和正确配置的难度越大。

从图中可以看出,定制编译内核具有巨大的影响力,但复杂度也相对较高。相比之下,参数调优和内存管理虽然影响力也很大,但实施起来相对简单一些。进行优化决策时,应权衡这些因素。

Linux内核优化核心概念图

下图通过思维导图的形式,概述了Linux内核优化的主要方面和相互关联的核心概念。这有助于您从宏观上理解内核优化的全貌。

(Linux Kernel Optimization)"] id1["内核版本选择

(Kernel Version Selection)"] id1_1["LTS (长期支持)"] id1_2["Mainline (主线)"] id1_3["Real-time (实时)"] id2["内核参数调优

(Parameter Tuning)"] id2_1["sysctl & /proc"] id2_2["CPU调度

(kernel.sched_*)"] id2_3["内存管理

(vm.*)"] id2_3_1["vm.swappiness"] id2_3_2["vm.dirty_ratio"] id2_4["网络栈

(net.*)"] id2_4_1["net.core.somaxconn"] id2_4_2["net.ipv4.tcp_max_syn_backlog"] id2_5["文件系统

(fs.*, mount options)"] id2_5_1["noatime"] id3["定制内核编译

(Custom Kernel Compilation)"] id3_1["移除模块/驱动"] id3_2["处理器特定优化"] id3_3["make menuconfig"] id3_4["应用补丁"] id4["I/O优化

(I/O Optimization)"] id4_1["I/O调度器

(noop, deadline, cfq, bfq, kyber)"] id4_2["文件系统选择

(ext4, XFS, Btrfs)"] id4_3["挂载选项"] id5["CPU与中断优化

(CPU & Interrupt Optimization)"] id5_1["CPU亲和性 (taskset)"] id5_2["IRQ绑定 (smp_affinity)"] id5_3["节能特性调整"] id6["监控与诊断

(Monitoring & Diagnosis)"] id6_1["性能工具

(top, htop, vmstat, iostat, perf, ftrace)"] id6_2["日志分析

(dmesg, journalctl)"] id6_3["基准测试

(sysbench, fio)"] id7["安全性与稳定性

(Security & Stability)"] id7_1["内核安全模块

(SELinux, AppArmor)"] id7_2["资源限制 (ulimit)"] id8["实践方法

(Best Practices)"] id8_1["备份配置"] id8_2["渐进调整"] id8_3["充分测试"]

此概念图清晰地展示了从内核版本选择到参数微调,再到高级编译和监控的完整优化流程和关键技术点。

视频:Tuning Linux for Performance - I Wanna Go Fast! - Anthony Nocentino (英文)。该视频探讨了Linux性能调优的多个方面,包括内核参数和工具的使用,为实际操作提供了有价值的参考。

观看此类专业分享有助于更深入地理解性能调优的实际挑战和解决方案。视频中通常会结合具体案例和工具演示,帮助您将理论知识应用于实践。

监控、诊断与最佳实践

成功的内核优化依赖于细致的监控、准确的诊断以及遵循最佳实践。

监控与诊断工具

在进行任何优化之前和之后,使用性能监控工具来识别瓶颈和评估效果至关重要。

- 基础命令行工具:

top/htop: 实时显示系统进程的资源占用情况(CPU、内存)。vmstat: 报告虚拟内存统计信息,包括进程、内存、分页、块I/O、陷阱和CPU活动。iostat: 报告CPU统计信息和输入/输出统计信息,用于设备和分区。free: 显示系统中的可用和已用物理内存及交换内存总量。sar (System Activity Reporter): 收集、报告或保存系统活动信息,功能强大。dmesg: 显示内核环形缓冲区的内容,有助于诊断硬件和驱动问题。journalctl: 查询和显示systemd日志。

- 高级性能分析工具:

perf: Linux下的性能分析工具,可以分析CPU性能计数器、跟踪点、kprobes和uprobes。ftrace: 内核内置的跟踪框架,用于分析内核函数调用、延迟等。SystemTap: 一个强大的脚本语言和工具,用于动态监测和跟踪运行中的Linux内核。eBPF (extended Berkeley Packet Filter): 一种内核技术,允许在内核空间安全地执行自定义代码,用于网络、跟踪和安全等多种用途。BCC和bpftrace是基于eBPF的常用工具。

Netdata等工具提供了直观的实时性能监控仪表盘。

最佳实践

- 明确优化目标: 在开始之前,明确您希望通过优化达到什么目标(例如,降低延迟、提高吞吐量、减少资源消耗)。

- 了解您的工作负载: 不同的应用和工作负载(CPU密集型、I/O密集型、网络密集型)需要不同的优化策略。

- 备份先行: 在对内核参数或配置进行任何重大更改之前,务必备份系统和重要数据。特别是编译新内核时,确保旧内核仍然可以引导。

- 小步快跑,渐进调整: 一次只更改一个或一小组相关的参数。这样更容易判断哪些更改带来了预期的效果,哪些没有,或者哪些导致了问题。

- 充分测试与验证: 在生产环境中应用任何优化措施之前,务必在测试环境中进行充分的测试和基准评估。使用与生产环境相似的负载进行测试。

- 文档化更改: 记录所做的每一次更改及其原因和效果。这有助于未来的故障排除和进一步优化。

- 保持系统更新: 定期更新您的Linux发行版和内核。新版本通常包含性能改进和安全修复。

- 自动化配置管理: 对于多台服务器的环境,使用Ansible、Puppet、Chef等配置管理工具来统一部署和管理内核参数,确保一致性。

- 参考社区与文档: Linux内核和相关工具的文档是宝贵的资源。参与社区讨论,学习他人的经验。

常见问题解答 (FAQ)

sysctl 和 /proc 文件系统在内核优化中扮演什么角色?

推荐探索

要进一步深化您对Linux内核优化的理解,可以探索以下相关主题:

- 如何为特定的工作负载选择最佳的Linux I/O调度器?

- 编译自定义Linux内核时有哪些常见的配置陷阱需要避免?

- 有哪些高级Linux性能监控工具可以用于识别内核瓶颈?

- 实时Linux内核(PREEMPT_RT)与标准内核在性能上有何不同?

参考资料

以下资源为本文提供了信息和灵感,您可以查阅它们以获取更深入的知识:

Last updated May 8, 2025