揭秘本地AI部署:选择最佳工具与分步指南

在您的个人设备上释放AI的力量,无需依赖云端。

在本地计算机或服务器上部署人工智能(AI)模型正变得越来越流行。这种方法提供了更好的隐私保护、离线可用性和定制化能力。但是,面对众多的工具和模型,选择合适的方案并成功部署可能令人望而生畏。本指南将为您详细介绍当前流行的本地AI部署选项,并提供详细的设置步骤和教程,帮助您轻松搭建自己的本地AI环境。

核心亮点

- 多种工具选择: 了解 Ollama、LocalAI、LM Studio 等流行本地AI框架的特点,找到最适合您需求的工具。

- 分步部署教程: 获取清晰、详细的安装和配置指南,包括使用 Docker 和图形化界面 (WebUI)。

- 硬件与隐私考量: 明确本地部署所需的硬件配置,并理解其在数据隐私方面的优势。

为何选择本地部署AI?

与依赖云服务商提供的AI API相比,在本地部署AI模型具有显著优势:

- 数据隐私与安全: 所有数据处理都在您的本地设备上完成,无需上传到第三方服务器,极大地增强了数据隐私和安全性。敏感信息不会离开您的控制范围。

- 离线运行: 一旦模型和框架部署完成,您可以在没有网络连接的情况下使用AI功能,这对于网络不稳定或需要离线工作的场景至关重要。

- 成本效益: 虽然初始硬件投入可能较高,但长期来看,本地部署可以避免按需付费API带来的持续性费用,特别是对于高频使用场景。

- 定制化与控制: 您可以更自由地选择、调整甚至微调模型以适应特定需求,而不受云服务商的限制。

- 低延迟: 本地处理通常比通过网络请求云API具有更低的延迟,响应速度更快。

流行的本地AI部署工具与框架

市面上有多种工具可以帮助您在本地运行AI模型。以下是一些备受推崇的选择:

Ollama

Ollama 是一个非常受欢迎的开源工具,旨在简化大型语言模型(LLM)的本地部署和运行过程。它支持 macOS、Windows 和 Linux,并拥有活跃的社区。

主要特点:

- 易于安装和使用,命令行操作简单。

- 支持多种流行的开源LLM,如 Llama 3.1, Mistral, DeepSeek 等。

- 可以轻松集成图形化界面,如 Open WebUI。

- 注重隐私保护和离线使用。

LocalAI

LocalAI 是一个免费、开源的 OpenAI API 替代品。它允许您在本地或私有云环境中运行 LLM、生成图像和音频,且兼容 OpenAI 的 API 格式,方便迁移现有应用。

主要特点:

- 提供与 OpenAI 兼容的 REST API 接口。

- 支持多种模型系列和架构,包括文本生成、图像生成、音频转录等。

- 可以在消费级硬件上运行。

- 可以通过 Docker 轻松部署。

LM Studio

LM Studio 提供了一个用户友好的图形界面,用于发现、下载和运行本地LLM。它特别适合希望简化操作流程的用户。

主要特点:

- 直观的图形用户界面 (GUI)。

- 内置模型浏览器,方便查找和下载模型。

- 强调用户数据隐私,不追踪用户操作。

- 对新手友好。

其他值得关注的选项

- Llama.cpp: 专注于在各种硬件(包括CPU)上高效运行 Llama 系列模型,性能优化出色。

- Stable Diffusion WebUI: 主要面向本地图像生成,提供了丰富的扩展和精细的控制选项,是运行 Stable Diffusion 模型的流行选择。

- AnythingLLM: 专注于文档处理和知识库构建,适合需要与自有文档交互的场景,支持团队协作。

- DeepSeek Models: DeepSeek 公司开源的一系列模型,性能优异,可以通过 Ollama 或其他框架进行本地部署。

工具特性对比雷达图

下图比较了几种流行的本地AI工具在不同维度上的表现。评分基于普遍认知和用户反馈,分数越高表示在该维度上表现越好(例如,易用性越高,得分越高;硬件要求越高,得分越低)。

请注意: 此图表评分基于综合印象,实际体验可能因具体模型、硬件和使用场景而异。

硬件与环境准备

在开始部署之前,请确保您的系统满足基本要求:

硬件要求

- 处理器 (CPU): 现代多核处理器即可,但对于某些计算,CPU 可能成为瓶颈。

- 内存 (RAM): 建议至少 16GB RAM,对于运行较大的模型,32GB 或更多更佳。

- 显卡 (GPU): 这是运行大型模型的关键。推荐使用 NVIDIA GPU,显存 (VRAM) 是重要指标,通常建议 8GB VRAM 起步,12GB、16GB 或 24GB+ 会有更好的性能和支持更多大型模型。AMD GPU 的支持正在改善,但兼容性可能不如 NVIDIA。

- 存储空间: 需要足够的硬盘空间来存储框架、模型文件(可能单个模型就达几十GB)和操作系统。推荐使用 SSD 以获得更快的加载速度。

软件环境

- 操作系统: 大多数工具支持 Windows, macOS 和 Linux。

- Docker (推荐): 许多工具(如 LocalAI, Open WebUI)推荐或需要使用 Docker 进行部署。Docker 可以简化环境配置和依赖管理。请访问 [Docker 官网](https://www.docker.com/get-started) 下载并安装。

- Python 和 Pip (可能需要): 某些工具或脚本可能需要 Python 环境。可以访问 [Python 官网](https://www.python.org/downloads/) 下载安装。

- GPU 驱动: 如果您计划使用 GPU 加速,请确保安装了最新的 NVIDIA 驱动程序 (CUDA Toolkit) 或 AMD ROCm 驱动。

本地AI部署流程思维导图

下图展示了本地部署 AI 的一般流程:

详细部署教程

方法一:使用 Ollama (推荐,易用性高)

Ollama 是在本地运行 LLM 的绝佳起点。

步骤:

- 下载并安装 Ollama: 访问 [Ollama 官网](https://ollama.com/),下载适合您操作系统(Windows, macOS, Linux)的安装程序并完成安装。

- 运行模型: 打开终端或命令行工具。选择一个您想运行的模型(例如 `llama3.1`),然后运行命令:

首次运行时,Ollama 会自动下载模型文件。下载完成后,您就可以在命令行直接与模型交互了。您可以在 Ollama 官网的 "Models" 页面找到更多可用模型及其运行命令。ollama run llama3.1 - (可选) 安装图形化界面 (Open WebUI): 如果您更喜欢图形界面,可以安装 Open WebUI。

- 确保已安装 Docker。

- 在终端运行以下 Docker 命令来启动 Open WebUI:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main - 等待容器启动后,在浏览器中访问 `http://localhost:3000`。首次访问需要注册一个本地账户。之后,您就可以通过网页界面选择和使用由 Ollama 管理的模型了。

方法二:使用 LocalAI (兼容 OpenAI API)

如果您需要一个与 OpenAI API 兼容的本地接口,LocalAI 是个不错的选择。

步骤:

- 安装 Docker: 确保您的系统已安装 Docker。

- 拉取 LocalAI 镜像: 在终端运行以下命令:

docker pull localai/localai - 运行 LocalAI 容器:

这将在本地 8080 端口启动 LocalAI 服务。docker run -p 8080:8080 --name localai localai/localai - 下载和配置模型: LocalAI 需要您手动下载模型文件并配置。您需要创建一个 `models` 文件夹,并将模型文件放入其中。然后,创建一个 `.yaml` 配置文件来指定模型名称、参数和文件路径。详细配置方法请参考 [LocalAI 官方文档](https://localai.io/basics/getting_started/)。

- 通过 API 交互: 配置完成后,您可以使用与 OpenAI API 相同的格式向 `http://localhost:8080/v1/` 发送请求。

- 安全提示: 如果您需要从其他机器访问 LocalAI,请务必确保 API 端点的安全,例如使用防火墙规则或设置 `API_KEY`。

方法三:使用 LM Studio (图形界面优先)

LM Studio 提供了一个纯图形化界面的体验。

步骤:

- 下载并安装 LM Studio: 访问 [LM Studio 官网](https://lmstudio.ai/) 下载适用于您系统的安装包并安装。

- 浏览和下载模型: 打开 LM Studio 应用,使用内置的模型浏览器搜索您感兴趣的模型(如 Llama, Mistral, Phi 等),然后点击下载。

- 聊天和配置: 在 "Chat" 标签页选择已下载的模型,即可开始交互。您可以在右侧面板调整模型参数。LM Studio 也可以启动一个本地推理服务器,供其他应用调用。

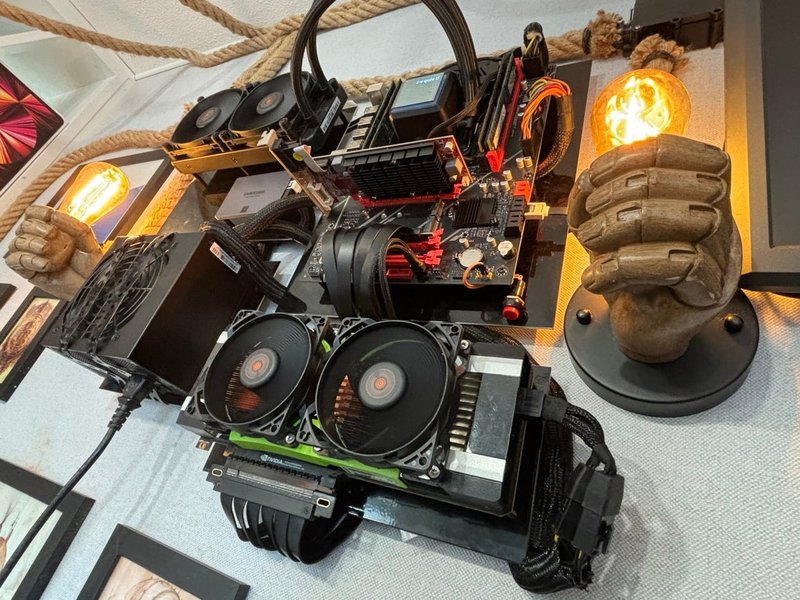

搭建您的本地 AI 工作站

成功部署本地 AI 不仅仅是软件配置,合适的硬件设置同样重要。许多爱好者和专业人士会组装专门的 AI 工作站或服务器,以获得最佳性能和体验。以下是一些本地 AI 硬件设置的示例,展示了从桌面工作站到小型服务器机房的不同规模。

这些设置通常包含强大的 GPU(例如 NVIDIA RTX 系列或专业级显卡)、充足的 RAM 和快速存储,以满足大型模型的需求。良好的散热和电源供应也是关键考虑因素。

本地AI部署工具对比

下表总结了前面讨论的主要本地 AI 部署工具的特点、优点和缺点,帮助您根据需求进行选择。

| 工具 | 主要特点 | 优点 | 缺点 | 适合用户 |

|---|---|---|---|---|

| Ollama | 命令行工具,易于安装和运行LLM,支持多种模型,可集成WebUI | 简单易用,跨平台,社区活跃,模型库丰富,离线友好 | 命令行初学者可能需要适应,高级定制选项相对较少 | 新手、开发者、希望快速部署和运行LLM的用户 |

| LocalAI | OpenAI API兼容的本地替代品,支持文本、图像、音频模型 | API兼容性好,方便迁移应用,支持多种模型类型,开源免费 | 配置相对复杂,需要手动管理模型文件和配置 | 需要OpenAI兼容API、希望自托管多种类型AI服务的开发者 |

| LM Studio | 图形用户界面 (GUI),内置模型浏览器和聊天界面 | 非常易用,无需命令行,方便发现和管理模型,隐私保护好 | 功能相对封闭,定制化能力不如命令行工具,资源占用可能较高 | 非技术用户、喜欢图形界面、希望简化操作流程的用户 |

| Stable Diffusion WebUI | 专注于图像生成的图形界面 | 功能强大,扩展丰富,对图像生成有精细控制 | 主要用于图像生成,界面选项繁多可能令新手困惑,硬件要求高 | 艺术家、设计师、对本地图像生成有高要求的用户 |

| Llama.cpp | C/C++实现,专注于高效运行Llama系列模型 | 性能极高,资源占用相对较低,跨平台支持好,可在CPU上运行 | 主要是命令行工具,需要编译或下载预编译版本,配置灵活性一般 | 追求极致性能、资源受限环境、需要CPU运行的用户、开发者 |

视频教程:搭建您的本地AI服务器

观看下面的视频,了解如何使用 Ollama 和 Open WebUI 搭建一个功能齐全的本地 AI 平台。这个教程覆盖了从安装到使用的完整流程,非常适合希望通过图形界面与本地模型交互的用户。

这个视频("Self-Host a local AI platform! Ollama + Open WebUI")展示了如何结合 Ollama 的模型管理能力和 Open WebUI 的友好界面,创建一个强大的私有 AI 环境。它涵盖了 Docker 的使用,是实践本地部署的好例子。

常见问题解答 (FAQ)

参考资料

- Getting started - LocalAI

- Ollama - Official Website

- LM Studio - Discover, download, and run local LLMs

- Deploy Local AI LLMs Easily with Ollama - API Dog Blog

- Setting up Local Generative AI Tools - NYU Libraries

- Best LLM Tools to Run Models Locally - Unite.AI

- Stable Diffusion WebUI - GitHub

推荐探索

Last updated April 5, 2025