解锁 PyTorch 2.6.0 的 GPU 加速:CUDA 版本全解析

深入了解 PyTorch 2.6.0 支持的 CUDA 版本、安装技巧和兼容性要点,充分发挥您的硬件潜能。

PyTorch作为一款广受欢迎的深度学习框架,其对 NVIDIA CUDA 技术的支持是实现 GPU 加速的关键。随着 PyTorch 2.6.0 版本的发布,开发者们普遍关心它所兼容的 CUDA 版本。理解正确的 CUDA 版本配置对于确保最佳性能、避免兼容性问题至关重要。

核心亮点

- 主要支持 CUDA 12.6:PyTorch 2.6.0 的开发和测试重点围绕 CUDA 12.6 进行,官方实验性 Linux 二进制文件也基于 CUDA 12.6.3 构建。

- 兼容多个 CUDA 版本:除了 12.6,PyTorch 2.6.0 也对 CUDA 12.4 和 CUDA 12.1 提供了良好的兼容性。

- 安装注意事项:通过 pip 安装时,建议使用指向特定 CUDA 版本的索引 URL(如

--index-url https://download.pytorch.org/whl/cu126),以确保 PyTorch 利用系统中已有的 CUDA 环境,避免版本冲突。

PyTorch 2.6.0 支持的 CUDA 版本详解

PyTorch 2.6.0 在 CUDA 版本支持方面提供了灵活性,但也有明确的推荐和侧重。理解这些差异有助于您根据自己的环境做出最佳选择。

CUDA 12.6:官方推荐与核心支持

PyTorch 2.6.0 的一个重要更新是计划迁移并主要支持 CUDA 12.6。官方发布博客明确指出,实验性的 Linux 二进制文件(包括 Aarch64、ROCm 6.2.4 和 XPU)是使用 CUDA 12.6.3 构建的。这表明团队已将 CUDA 12.6 作为此版本 PyTorch 的核心优化目标。

社区关于 PyTorch 与 CUDA 版本兼容性的讨论截图

选择 CUDA 12.6 的优势在于:

- 最新特性和优化:能够充分利用 CUDA 12.6 带来的最新 GPU 加速特性和性能改进。

- 官方二进制文件:可以直接使用官方提供的预编译包,简化安装过程。

- 未来兼容性:作为重点支持版本,未来 PyTorch 的更新可能会更侧重于与此版本的 CUDA 配合。

对于希望获得最佳性能和最新功能的用户,尤其是在 Linux 环境下,CUDA 12.6 是 PyTorch 2.6.0 的首选。

CUDA 12.4 和 CUDA 12.1:可靠的兼容选项

除了 CUDA 12.6,PyTorch 2.6.0 也对 CUDA 12.4 和 CUDA 12.1 保持了良好的兼容性。一些用户报告称,即使在尝试安装 cu126 标记的 wheel 包时,pip 安装的依赖中可能实际包含的是 CUDA 12.4 的运行时。这通常是为了更广泛的兼容性而设计的。

CUDA 12.4

CUDA 12.4 是一个稳定且广泛使用的版本。如果您的系统已配置 CUDA 12.4,PyTorch 2.6.0 通常可以无缝运行。安装时,可以使用类似 pip install torch==2.6.0+cu124 的命令指定此版本。

CUDA 12.1

NVIDIA 的 CUDA 平台具有良好的向后兼容性,这意味着为较新版本 CUDA 编译的 PyTorch 通常可以在安装了稍旧 CUDA 工具包(如 12.1)的系统上运行,只要驱动程序版本足够新。PyTorch 的官方支持矩阵也通常会包含对这类版本的兼容性说明。

关于 CUDA 11.8 的说明

虽然有讨论提及 PyTorch 2.6 可能支持 CUDA 11.8,但这主要源于早期的 RFC(Request for Comments)文档,并非 PyTorch 2.6.0 发布时的核心推荐。大部分最新信息和官方二进制文件都指向了 CUDA 12.x 系列。Answer D 中提到的 PyTorch 2.6.0 支持 CUDA 11.8 并提供了相应的安装命令,这与多数信息源(A, B, C)不符,后者均强调 CUDA 12.6 为主要支持版本,并提及 12.4 和 12.1。官方历史版本页面显示的是较早的 PyTorch 版本(如2.0.1)与 CUDA 11.8 的组合。因此,对于 PyTorch 2.6.0,主要关注点应放在 CUDA 12.x 版本上。

CUDA 版本选择与 PyTorch 2.6.0 性能考量

为了更直观地展示不同 CUDA 版本在与 PyTorch 2.6.0 配合使用时的考量因素,以下雷达图提供了一个基于综合信息的概览。这些评估是基于普遍认知和官方信息的解读,具体表现可能因系统配置和工作负载而异。

此雷达图比较了 CUDA 12.6、12.4 和 12.1 在与 PyTorch 2.6.0 结合使用时的几个关键方面:官方推荐度指 PyTorch 团队对此 CUDA 版本的侧重程度;新特性支持度和预期性能优化反映了版本新旧带来的潜力;向后兼容性考量了对旧有环境和代码的友好度;社区支持广泛度涉及问题解决和资源获取的便利性;预装环境依赖度则暗示了安装时对系统现有 CUDA 的依赖程度(数值越低,越倾向于自带或易于配置)。

安装 PyTorch 2.6.0 与 CUDA:关键步骤与注意事项

正确安装 PyTorch 并使其能够利用 CUDA 加速是深度学习工作流程的第一步。以下是一些关键的安装指南和需要注意的事项。

选择正确的安装命令

PyTorch 官方提供了便捷的 pip 安装指令生成器。通常,您需要选择操作系统、包管理器 (Pip)、语言 (Python) 和计算平台(CUDA 版本)。

例如,为使用 CUDA 12.6,您可能会使用类似以下的命令:

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126对于 CUDA 12.4,则可能是:

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124--index-url 的重要性

使用 --index-url 参数指向 PyTorch 官方为特定 CUDA 版本提供的 wheel 文件仓库至关重要。这种方式通常假定您的系统中已经安装了对应版本的 CUDA 工具包和驱动。PyTorch 安装包本身可能不会捆绑完整的 CUDA 运行时,而是链接到您系统中的现有安装。

如果直接使用 pip install torch==2.6.0,pip 可能会选择一个它认为最兼容的预编译包,这可能导致安装的 PyTorch 内部链接的 CUDA 版本与您系统中的 CUDA 版本不完全一致,或捆绑了特定版本的 CUDA 运行时(如 CUDA 12.4),即使您期望的是 CUDA 12.6。

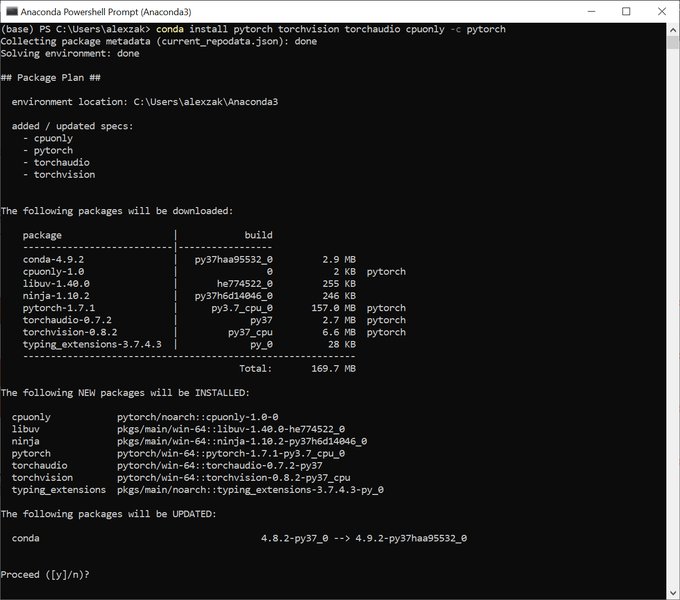

通过 Anaconda Prompt 安装 PyTorch 的示例界面

检查 CUDA 环境

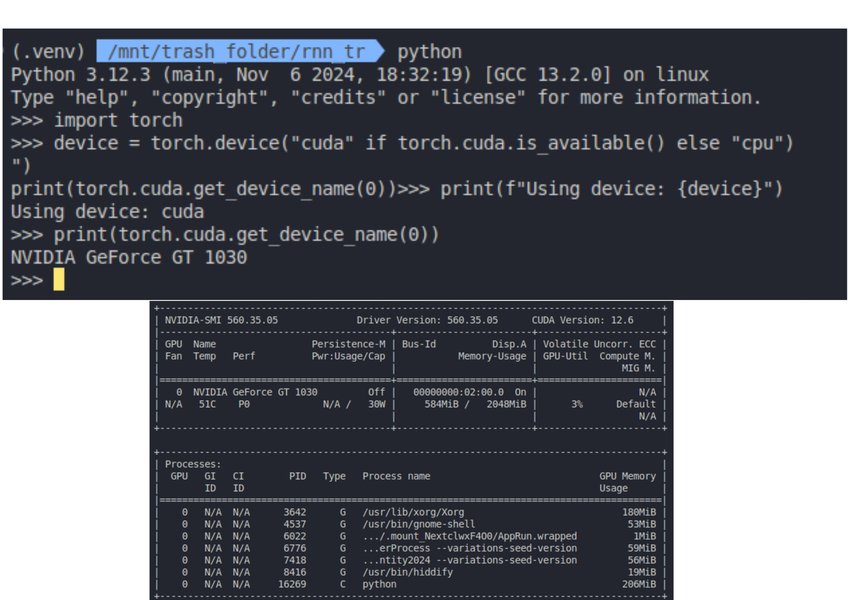

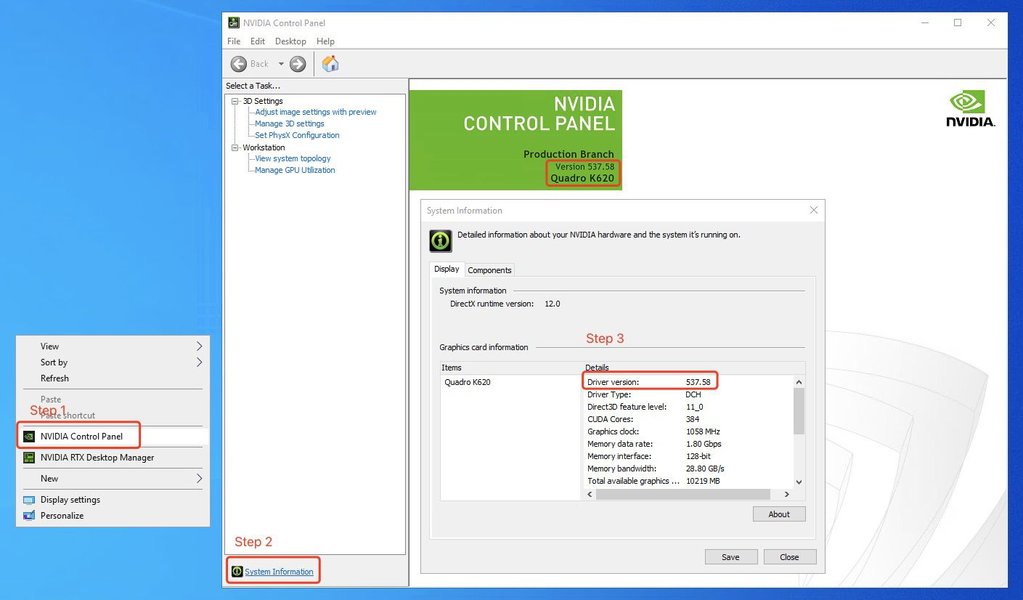

在安装 PyTorch 之前和之后,验证您的 CUDA 环境和 PyTorch 的 CUDA 支持状态非常重要:

- 检查 NVIDIA 驱动和 CUDA 工具包版本:在终端运行

nvidia-smi命令可以查看已安装的 NVIDIA 驱动版本以及该驱动支持的最高 CUDA 版本。您还需要确保已安装了与目标 PyTorch 版本兼容的 CUDA Toolkit。 - 验证 PyTorch CUDA 可用性:在 Python 环境中运行以下代码:

import torch print(f"PyTorch version: {torch.__version__}") print(f"CUDA available: {torch.cuda.is_available()}") if torch.cuda.is_available(): print(f"CUDA version: {torch.version.cuda}") print(f"Number of GPUs: {torch.cuda.device_count()}") print(f"GPU Name: {torch.cuda.get_device_name(0)}")

使用 nvidia-smi 检查 NVIDIA 驱动和 CUDA 版本

依赖项和兼容性问题

CUDA 依赖缺失

有时,即使指定了正确的 CUDA wheel (如 whl/cu126 或 +cu126),PyTorch 也可能不会自动安装所有的 CUDA 核心依赖。这是因为 PyTorch 的这些 wheel 文件设计为依赖系统中预装的 CUDA Toolkit。如果您的环境中没有完整的 CUDA 12.6 (或其他目标版本),torch.cuda.is_available() 可能会返回 False。

例如,有用户反映在安装 torch==2.6.0 并使用 whl/cu126 索引时,若环境中已预装 CUDA 12.6,则 PyTorch 会正确链接到这些本地依赖,pip 本身不会再下载 CUDA 相关的库。这是一个预期的行为,旨在减小 PyTorch wheel 包的体积并利用系统级 CUDA 安装。

然而,GitHub issue 146679 报告了 torch 2.6.0 cu126 wheel 相较于 cu124 wheel 可能缺少某些依赖的情况。这提示用户在选择版本时需仔细验证。

CXX11_ABI 兼容性

PyTorch 2.6 的实验性 Linux 二进制文件使用 CXX11_ABI=1 构建。如果您正在构建自定义的 C++ 或 CUDA 扩展,也需要确保它们以相同的 ABI 版本编译,以避免链接时错误。

特定平台考量

Linux

Linux 是 PyTorch 和 CUDA 支持最成熟的平台。官方的 PyTorch 2.6.0 Linux 二进制文件(x86_64 和 Aarch64)均附带 CUDA 12.6.3 支持。

Jetson 平台 (如 Orin Nano)

对于 NVIDIA Jetson 设备,情况可能更复杂。例如,Jetson Orin Nano 配合 JetPack 6.2 (包含 Ubuntu 22.04 和 CUDA 12.6) 时,理论上应安装 torch-2.6.0-cp310-cp310-linux_aarch64.whl。然而,社区讨论中也常建议针对 Jetson 平台寻找特定编译的 PyTorch wheel,或在遇到官方版本问题时考虑使用 JetPack 版本对应的、经过验证的旧版 PyTorch (如 2.5) 或自行编译。

Anaconda 环境

从 PyTorch 2.6 开始,官方的 Anaconda 频道正在被弃用。通过 Anaconda 安装的用户可能需要寻找替代的安装源或方法,例如直接使用 pip 和官方 wheel 索引。

Docker 容器

使用 Docker 是管理复杂依赖环境(如 PyTorch 和 CUDA)的推荐方法。PyTorch 官方提供了包含不同 CUDA 版本的 Docker 镜像,例如 pytorch/pytorch:2.6.0-cuda12.6-cudnn9-devel,这些镜像预配置了所有必要的依赖,可以大大简化部署过程。

PyTorch 2.6.0 CUDA 支持概览图

下面的思维导图总结了 PyTorch 2.6.0 对不同 CUDA 版本的支持情况及其关键考量因素,帮助您快速理解核心信息。

该思维导图清晰地展示了 PyTorch 2.6.0 对 CUDA 12.6 的核心支持,同时列出了 CUDA 12.4 和 12.1 作为兼容选项。它还强调了安装过程中的关键步骤,如使用特定索引 URL、验证 CUDA 可用性,以及需要注意的依赖和平台特性。

PyTorch 2.6.0 CUDA 版本支持速查表

下表总结了 PyTorch 2.6.0 对主要相关 CUDA 版本的支持状态和一些关键说明,方便您快速查阅。

| CUDA 版本 | PyTorch 2.6.0 支持状态 | 关键说明 / Pip Wheel 后缀 |

|---|---|---|

| CUDA 12.6 (如 12.6.x) | 主要支持 / 官方推荐 | 实验性 Linux 二进制文件基于 CUDA 12.6.3 构建。推荐用于新项目和最佳性能。Wheel 后缀通常为 cu126。 |

| CUDA 12.4 | 兼容 | 广泛兼容,部分标准 pip 安装可能链接到此版本运行时。Wheel 后缀通常为 cu124。 |

| CUDA 12.1 | 兼容 | 通过 NVIDIA 的向后兼容性支持。适用于系统中已安装 CUDA 12.1 的情况。 |

| CUDA 11.8 | 早期 RFC 讨论,非 2.6.0 发布时重点 | PyTorch 2.6.0 主要转向 CUDA 12.x。若需此版本,请仔细核对特定构建或考虑旧版 PyTorch。 |

请注意,选择 CUDA 版本时,务必确保您的 NVIDIA 驱动程序版本与所选 CUDA 工具包版本兼容。通常,较新的驱动程序支持较旧和较新的 CUDA 工具包版本,直至驱动程序支持的上限。

视频教程:安装 PyTorch 与 CUDA 支持

对于希望通过视频指导完成 PyTorch 和 CUDA 安装的用户,下面的视频提供了在 Windows 系统上安装 PyTorch 并启用 CUDA 支持的步骤。虽然具体版本可能与 PyTorch 2.6.0 有所不同,但其展示的基本原则和检查步骤(如验证 CUDA 安装、检查 PyTorch 中的 GPU 可用性)对于任何版本的 PyTorch 和 CUDA 安装都具有参考价值。

该视频 "Step-by-Step Guide: Installing PyTorch with CUDA GPU ..." 详细介绍了如何在 Windows 环境下逐步安装支持 CUDA 的 PyTorch。它涵盖了从检查 GPU 兼容性、下载和安装 CUDA Toolkit,到最后通过 pip 安装 PyTorch 并验证 GPU 是否被成功识别和利用的过程。这些步骤对于确保您的深度学习环境正确配置至关重要。

常见问题解答 (FAQ)

torch==2.6.0 并指定 whl/cu126 后,CUDA 相关的依赖似乎没有被 pip 安装?

+

推荐探索

- 如何为PyTorch 2.6选择最佳CUDA版本以优化特定AI模型性能?

- PyTorch 2.6与旧版CUDA(如11.8)的详细兼容性分析和潜在风险是什么?

- 在Docker容器中部署PyTorch 2.6和CUDA 12.6的最佳实践有哪些?

- 解决PyTorch 2.6中torch.cuda.is_available()返回False的常见步骤和技巧是什么?

参考资料

Last updated May 11, 2025