在 Windows 上为 CUDA 12.2 安装兼容的 PyTorch:终极指南

解锁您 NVIDIA GPU 的强大功能,在 Windows 系统上配置 PyTorch 与 CUDA 12.2 的无缝协作。

您好!您正在寻找在 Windows 系统上安装与 CUDA 12.2 兼容的 PyTorch (Torch) 版本的方法。虽然 PyTorch 官方可能尚未为 CUDA 12.2 提供直接的预编译二进制文件,但有多种行之有效的方法可以实现这一目标。本指南将详细介绍兼容性情况、先决条件、安装步骤以及验证方法,助您顺利完成配置。

核心洞察

- 官方支持情况: PyTorch 官方主要提供针对 CUDA 11.8 和 CUDA 12.1 的预编译包。目前,直接标记为 CUDA 12.2 的官方稳定版 PyTorch 轮子文件可能较少或处于实验阶段。

- 兼容性利用: 得益于 NVIDIA CUDA 的向前和向后兼容性,为 CUDA 12.1 构建的 PyTorch 版本通常可以在安装了 CUDA 12.2 驱动和工具包的 Windows 系统上良好运行。

- 推荐安装途径: 使用

pip并指定针对 CUDA 12.1 (cu121) 的额外索引 URL,或在特定情况下尝试针对cu122的实验性 URL,是首选方法。conda也是一个管理依赖项的强大选项。

深入了解 PyTorch 与 CUDA 12.2 的兼容性

官方立场与社区实践

截至 2025 年 5 月,PyTorch 官方的“Get Started”页面主要列出了对 CUDA 11.8 和 CUDA 12.1 的支持。这意味着您可能找不到一个直接标记为“for CUDA 12.2”的稳定版官方下载选项。然而,这并不意味着无法在 CUDA 12.2 环境下使用 PyTorch。

NVIDIA 的 CUDA 平台设计具有一定程度的兼容性。通常,为较新次要版本(如 CUDA 12.1)编译的库可以在具有更新的次要版本驱动(如 CUDA 12.2)的系统上运行。许多开发者社区的报告和论坛讨论证实,使用为 CUDA 12.1 构建的 PyTorch 版本(例如 PyTorch 2.1.x 或更高版本)可以在已安装 CUDA Toolkit 12.2 和相应驱动程序的 Windows 系统上成功运行并利用 GPU 加速。

此外,PyTorch 社区和开发者有时会提供针对更新 CUDA 版本的实验性或测试性轮子文件,这些可以通过特定的 pip 命令进行安装。

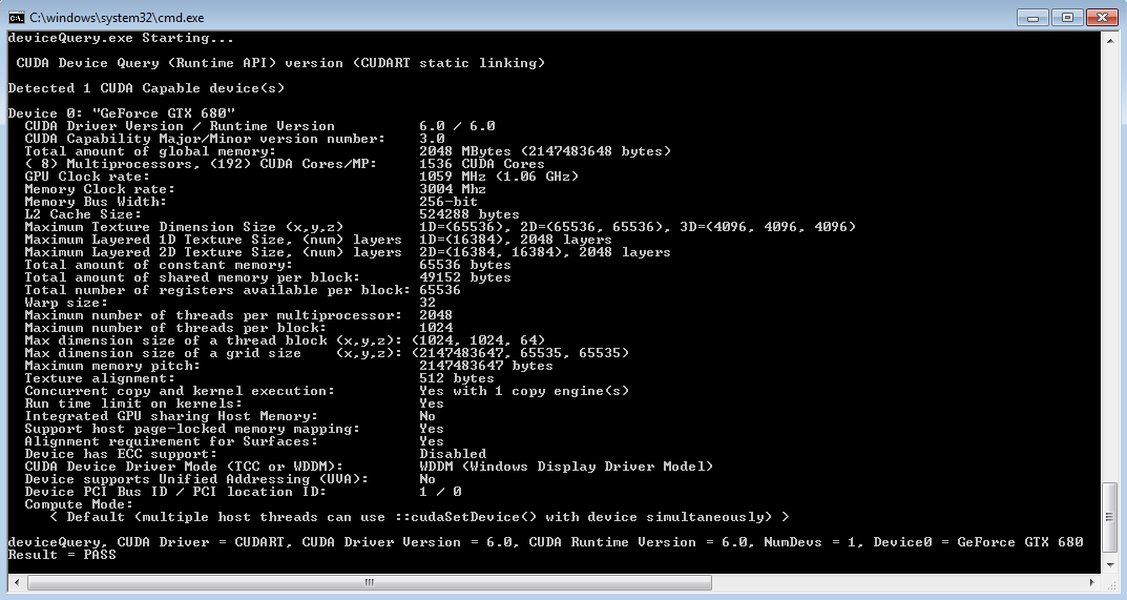

在 Windows 上配置 PyTorch 以利用 GPU 加速的示意图。

安装前的准备工作:确保万无一失

系统要求与必备软件

在开始安装 PyTorch 之前,请确保您的 Windows 系统满足以下条件:

-

NVIDIA 显卡驱动程序

安装最新且与 CUDA 12.2 兼容的 NVIDIA 显卡驱动程序。通常,驱动程序版本应为 535.xx 或更高。您可以从 NVIDIA 官方驱动下载页面 获取。

-

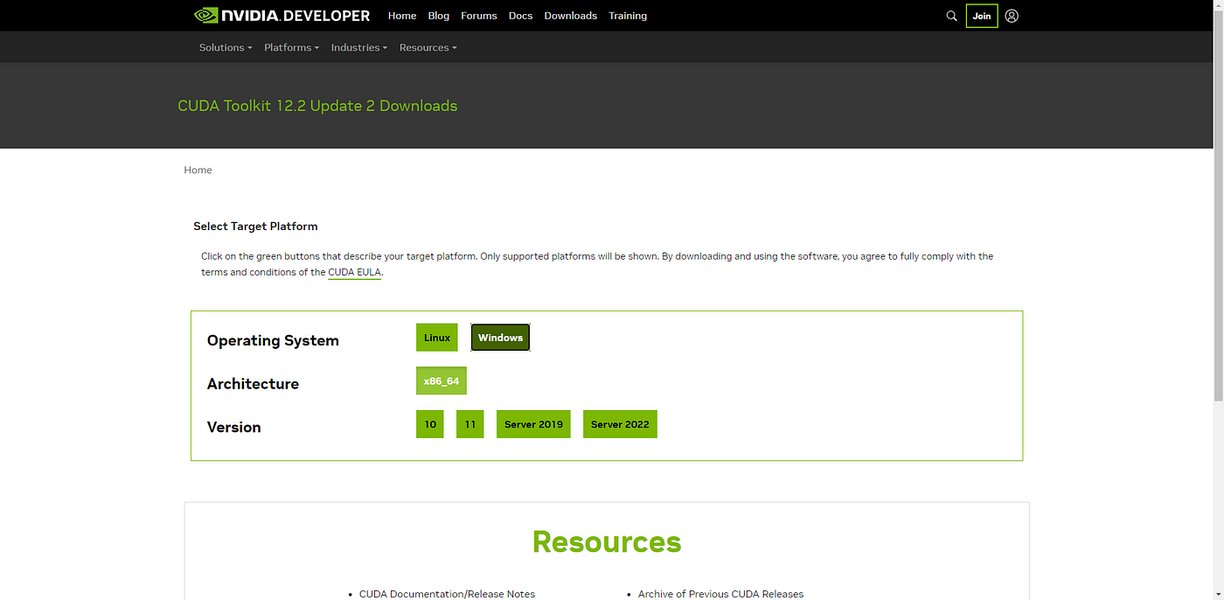

CUDA Toolkit 12.2

从 NVIDIA CUDA Toolkit Archive 下载并安装 CUDA Toolkit 12.2。安装完成后,可以通过在命令提示符或 PowerShell 中运行

nvcc -V来验证安装,应显示 CUDA 12.2 版本信息。

通过

nvcc -V命令验证 CUDA Toolkit 安装成功。 -

cuDNN (可选但推荐)

NVIDIA CUDA® Deep Neural Network library (cuDNN) 是一个 GPU 加速的深度神经网络基元库。为获得最佳性能,建议安装与 CUDA 12.2 兼容的 cuDNN 版本(例如 cuDNN 8.9.x 或更高版本)。您可以从 NVIDIA cuDNN 下载页面 获取 (需要注册 NVIDIA 开发者账户)。下载后,按照官方文档将其相关 DLL 文件复制到 CUDA Toolkit 的安装目录中。

-

Python 环境

建议使用 Anaconda 或 Miniconda 来创建和管理独立的 Python 环境,以避免与其他库产生冲突。推荐 Python 3.8 - 3.11 版本。 如果您尚未安装 Anaconda,可以从 Anaconda Distribution 下载。

Anaconda 环境设置界面,推荐用于管理 Python 包。

创建一个新的 conda 环境:

conda create -n pytorch_cuda12 python=3.10 conda activate pytorch_cuda12确保 pip 已更新:

pip install --upgrade pip

在 Windows 上安装 PyTorch:多种途径

以下是在 Windows 上安装与 CUDA 12.2 兼容的 PyTorch 的主要方法:

方法一:使用 Pip 和特定索引 URL (推荐)

这是最直接的方法,通过指定 PyTorch 官方提供的特定 CUDA 版本的轮子文件 (wheel) 仓库进行安装。

选项 A: 安装 CUDA 12.1 兼容版本 (高稳定性)

由于 CUDA 12.1 的 PyTorch 包在 CUDA 12.2 环境下具有良好的兼容性,这是目前最稳妥的选择:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121此命令会安装与 CUDA 12.1 捆绑的 PyTorch、torchvision 和 torchaudio。这些包通常包含了所需的 CUDA 运行时依赖。

选项 B: 尝试安装 CUDA 12.2 实验性/特定版本 (按需尝试)

某些情况下,PyTorch 可能会提供针对较新 CUDA 版本的实验性轮子文件。您可以尝试以下命令,但请注意其稳定性可能不如 cu121 版本:

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu122如果此命令成功,它将安装针对 CUDA 12.2 构建的 PyTorch 版本。如果失败或找不到匹配的包,请回退到选项 A。

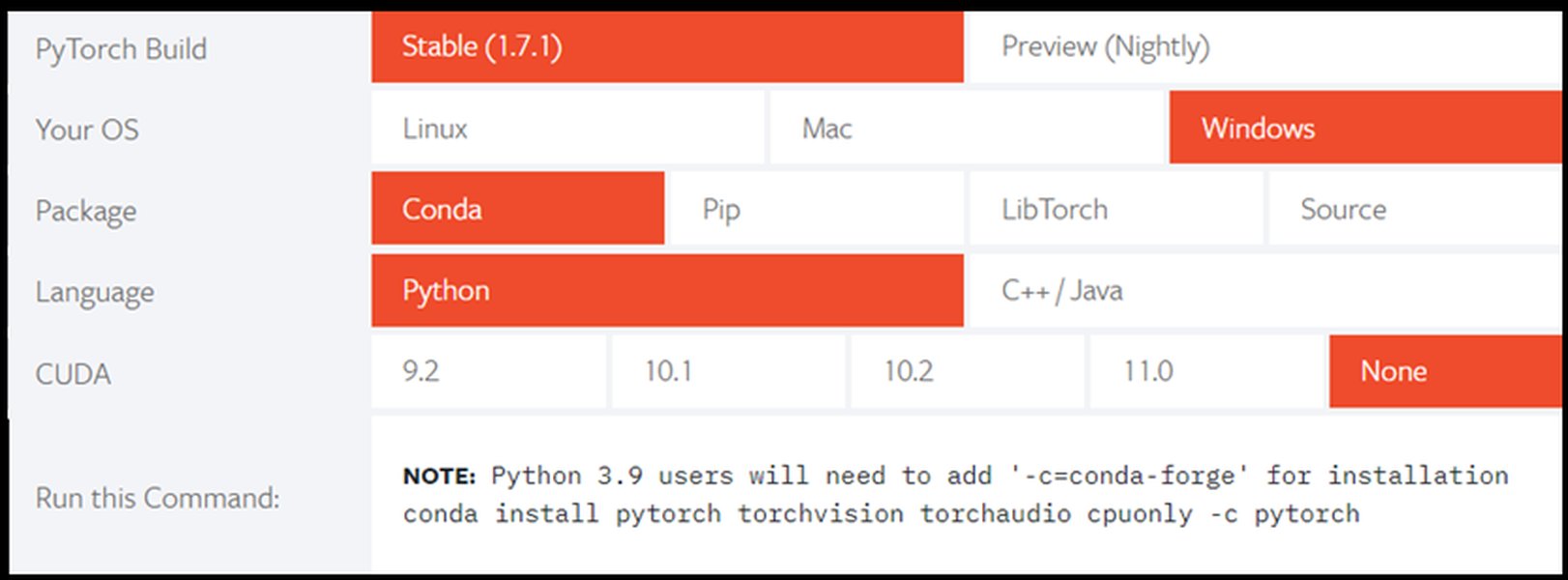

方法二:使用 Conda 安装

Conda 是一个优秀的环境和包管理器,可以很好地处理复杂的依赖关系。

安装 CUDA 12.1 兼容版本

您可以使用以下命令通过 conda 安装与 CUDA 12.1 兼容的 PyTorch:

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia此命令会从 PyTorch 和 NVIDIA 的 conda 频道安装必要的包,并指定 CUDA 版本为 12.1。同样,这个版本通常能在 CUDA 12.2 环境下工作。

在某些情况下,如果遇到问题,也可以尝试安装基于 CUDA 11.8 的 PyTorch,因为它也被报道可以在 CUDA 12.x 环境下工作:

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia方法三:从源代码编译 (高级用户)

如果您对特定的 CUDA 12.2 功能有严格要求,并且上述方法无法满足,您可以选择从 PyTorch 的 GitHub 仓库克隆源代码,并针对您本地的 CUDA 12.2 环境进行编译。这是一个复杂且耗时的过程,需要安装 Visual Studio、CMake 等构建工具,并仔细配置编译选项。详细步骤请参考 PyTorch 官方的从源码安装指南。

安装方法比较

下表总结了不同安装方法的关键特性,帮助您做出选择:

| 特性 | Pip (cu121) | Pip (cu122 - 实验性) | Conda (pytorch-cuda=12.1) | 从源码编译 |

|---|---|---|---|---|

| 安装命令示例 | pip install torch... --index-url .../whl/cu121 |

pip install torch... --extra-index-url .../whl/cu122 |

conda install pytorch... pytorch-cuda=12.1 ... |

python setup.py install ... |

| 易用性 | 高 | 中 (可能不稳定) | 高 | 低 (复杂) |

| CUDA 12.2 直接支持 | 间接 (通过兼容性) | 直接 (如果可用) | 间接 (通过兼容性) | 直接 (需手动配置) |

| 稳定性 | 高 | 中至低 | 高 | 取决于配置 |

| 依赖管理 | 中 | 中 | 强 | 手动 |

| 官方推荐度 (针对12.2环境的变通) | 高 | 谨慎尝试 | 高 | 高级用户备选 |

安装策略评估雷达图

下图通过雷达图形式直观比较了不同安装策略在关键因素上的表现。这些评估基于普遍的经验和社区反馈,旨在为您提供决策参考。数值越高代表在该维度上表现越优或越符合期望(例如,“易用性”越高越好,“CUDA 12.2 特异性”越高表示越针对12.2版本)。

此雷达图旨在提供一个概览。例如,“Conda (pytorch-cuda=12.1)”在易用性、稳定性和依赖管理方面表现优异,而“从源码编译”在 CUDA 12.2 特异性上得分最高,但易用性较低。

PyTorch CUDA 12.2 安装决策思维导图

这个思维导图概括了在 Windows 上为 CUDA 12.2 安装 PyTorch 的决策流程和关键考虑因素,帮助您系统地规划安装过程。

on Windows"] id1["环境准备 (Prerequisites)"] id1_1["NVIDIA 驱动

(最新兼容版)"] id1_2["CUDA Toolkit 12.2

(

nvcc -V 验证)"]

id1_3["cuDNN (可选但推荐性能)"] id1_4["Python 环境

(Anaconda/Miniconda 推荐)"] id1_4_1["创建虚拟环境"] id1_4_2["更新 pip"] id2["安装选项 (Installation Options)"] id2_1["Pip 命令"] id2_1_1["--index-url .../whl/cu121

(稳定推荐)"] id2_1_2["--extra-index-url .../whl/cu122

(实验性, 按需尝试)"] id2_2["Conda 命令"] id2_2_1["pytorch-cuda=12.1

(稳定推荐)"] id2_2_2["pytorch-cuda=11.8

(备选方案)"] id2_3["从源码编译

(高级用户, 完全控制)"] id3["验证安装 (Verification)"] id3_1["Python 脚本"] id3_1_1["

import torch"]

id3_1_2["torch.cuda.is_available()应为 True"] id3_1_3["

torch.version.cuda显示CUDA版本"] id3_1_4["

torch.cuda.get_device_name(0)"]

id4["故障排除与优化 (Troubleshooting & Optimization)"]

id4_1["GPU 未检测到"]

id4_2["版本冲突"]

id4_3["性能调优(AMP, DataLoader)"]

通过这个思维导图,您可以清晰地看到从准备工作到安装验证的每一步,以及不同安装路径的选择依据。

验证您的 PyTorch CUDA 安装

安装完成后,务必验证 PyTorch 是否能够正确识别并使用您的 CUDA GPU。在您的 Python 环境 (例如,激活了的 conda 环境中的 Python解释器或 Jupyter Notebook) 中运行以下代码:

import torch

# 检查 CUDA 是否可用

cuda_available = torch.cuda.is_available()

print(f"CUDA available: {cuda_available}")

if cuda_available:

# 显示 PyTorch 使用的 CUDA 版本

# 注意:这可能是 PyTorch 编译时使用的 CUDA 版本,可能与系统安装的 CUDA Toolkit 版本略有不同,但应兼容

print(f"PyTorch CUDA version: {torch.version.cuda}")

# 显示当前 CUDA设备的数量

print(f"Number of CUDA devices: {torch.cuda.device_count()}")

# 获取并显示第一个 CUDA 设备的名称

if torch.cuda.device_count() > 0:

print(f"CUDA Device Name: {torch.cuda.get_device_name(0)}")

# 创建一个张量并将其移动到 GPU

try:

x = torch.rand(5, 3).cuda()

print("Tensor created on GPU successfully:")

print(x)

except Exception as e:

print(f"Error creating tensor on GPU: {e}")

else:

print("CUDA is not available. PyTorch will run on CPU.")

# 显示 PyTorch 版本

print(f"PyTorch version: {torch.__version__}")如果一切配置正确,torch.cuda.is_available() 应该返回 True,并且您能看到相关的 CUDA 版本信息和 GPU 名称。

观看视频教程:在 Windows 上安装 PyTorch 与 CUDA

以下视频提供了在 Windows 系统上安装 PyTorch 并配置 CUDA 支持的通用步骤,可以作为本指南的视觉补充。虽然视频可能不完全针对 CUDA 12.2,但其展示的安装流程和环境配置思路具有参考价值。

视频教程:如何在 Windows 上安装 PyTorch 并设置 CUDA (标题:How to install pytorch for cuda 12 2)。此视频演示了安装 CUDA Toolkit、cuDNN 以及 PyTorch 的过程,有助于理解在 Windows 环境下的操作步骤。

性能优化小贴士

充分发挥 GPU 潜能

成功安装后,您可以考虑以下几点来优化 PyTorch 在 CUDA 上的性能:

- 自动混合精度 (AMP): 使用

torch.cuda.amp可以通过在训练中使用半精度浮点数 (FP16) 来加速训练过程并减少显存占用,同时保持数值稳定性。 - 高效数据加载: 利用

torch.utils.data.DataLoader并设置num_workers大于 0,可以并行加载数据,减少 GPU 等待数据的时间。设置pin_memory=True可以加快数据从 CPU 到 GPU 的传输。 - 显存管理: 注意监控和管理 GPU 显存使用。可以通过

PYTORCH_CUDA_ALLOC_CONF环境变量调整 PyTorch 的 CUDA内存分配器行为,例如设置max_split_size_mb来避免内存碎片。 - 选择合适的批处理大小 (Batch Size): 在显存允许的范围内,适当增大批处理大小通常可以提高 GPU 的利用率和训练速度。

常见问题解答 (FAQ)

pip install torch ... --extra-index-url .../whl/cu122 命令失败或找不到包怎么办?

推荐探索

如果您希望进一步深入了解相关主题,可以尝试搜索以下内容:

- 如何在Windows上管理多个CUDA版本以兼容不同PyTorch项目?

- PyTorch CUDA内存不足错误的常见原因及解决方法有哪些?

- 比较不同PyTorch版本在NVIDIA最新GPU上的性能表现如何?

- 在Windows子系统Linux (WSL2)中安装和使用PyTorch与CUDA的步骤是什么?

参考资料

以下是本指南信息来源及有用的外部链接:

Last updated May 11, 2025